–£–љ–Є—Д–Є–Ї–∞—Ж–Є—П —В—А–∞–љ—Б–њ–Њ—А—В–∞ –¶–Ю–Ф

29 –Є—О–ї—П 2009 LANLAN

–Ш—О–ї—М, 2009 –≥.

http://www.osp.ru/lan/2009/07/9596544/

–°–µ—А–≥–µ–є –Ы–µ–±–µ–і–µ–≤, —В–µ—Е–љ–Є—З–µ—Б–Ї–Є–є —А—Г–Ї–Њ–≤–Њ–і–Є—В–µ–ї—М –љ–∞–њ—А–∞–≤–ї–µ–љ–Є—П "–°–µ—В–µ–≤–∞—П –Є–љ—Д—А–∞—Б—В—А—Г–Ї—В—Г—А–∞ –¶–Ю–Ф" , –Ю—В–Ї—А—Л—В—Л–µ –Ґ–µ—Е–љ–Њ–ї–Њ–≥–Є–Є

–Ю–њ—В–Є–Љ–Є–Ј–∞—Ж–Є—П —Б–Њ–±—Б—В–≤–µ–љ–љ–Њ–є –Є–љ—Д—А–∞—Б—В—А—Г–Ї—В—Г—А—Л –Ш–Ґ –њ–Њ–Ј–≤–Њ–ї—П–µ—В –Ї–Њ–Љ–њ–∞–љ–Є–Є –Ј–љ–∞—З–Є—В–µ–ї—М–љ–Њ —Б–Њ–Ї—А–∞—В–Є—В—М –Є–Ј–і–µ—А–ґ–Ї–Є –Є –њ–Њ–≤—Л—Б–Є—В—М –њ—А–Њ–і—Г–Ї—В–Є–≤–љ–Њ—Б—В—М. –Ю–і–љ–∞–Ї–Њ –њ—А–Є –≤—Л–±–Њ—А–µ —Б–њ–Њ—Б–Њ–±–Њ–≤ –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є —Б–љ–∞—З–∞–ї–∞ —Б–ї–µ–і—Г–µ—В –Њ—Ж–µ–љ–Є—В—М —Б—В—А—Г–Ї—В—Г—А—Г –Ј–∞—В—А–∞—В –љ–∞ –њ–Њ–і–і–µ—А–ґ–∞–љ–Є–µ —Д—Г–љ–Ї—Ж–Є–Њ–љ–Є—А–Њ–≤–∞–љ–Є—П –¶–Ю–Ф –Є —А–∞–Ј–Љ–µ—Й–µ–љ–љ—Л—Е –≤ –љ–µ–Љ –±–Є–Ј–љ–µ—Б-–њ—А–Є–ї–Њ–ґ–µ–љ–Є–є.

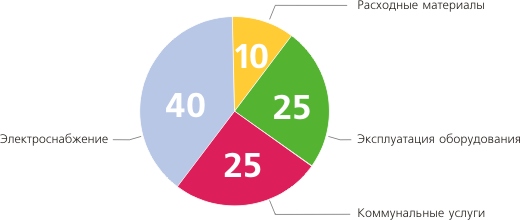

–°–Њ–≥–ї–∞—Б–љ–Њ –Њ—Ж–µ–љ–Ї–µ Uptime Institute, –∞ —В–∞–Ї–ґ–µ –љ–∞ –Њ—Б–љ–Њ–≤–∞–љ–Є–Є –Њ–њ—Л—В–∞ —А–Њ—Б—Б–Є–є—Б–Ї–Є—Е –Ї–Њ–Љ–њ–∞–љ–Є–є, —А–∞—Б—Е–Њ–і—Л –љ–∞ —Н–Ї—Б–њ–ї—Г–∞—В–∞—Ж–Є—О –¶–Ю–Ф —Б–Ї–ї–∞–і—Л–≤–∞—О—В—Б—П –Є–Ј —З–µ—В—Л—А–µ—Е –Ї–ї—О—З–µ–≤—Л—Е —Б–Њ—Б—В–∞–≤–ї—П—О—Й–Є—Е: –Ј–∞—В—А–∞—В—Л –љ–∞ —Н–ї–µ–Ї—В—А–Њ—Б–љ–∞–±–ґ–µ–љ–Є–µ (—Н–ї–µ–Ї—В—А–Њ–њ–Є—В–∞–љ–Є–µ –Є –Ї–Њ–љ–і–Є—Ж–Є–Њ–љ–Є—А–Њ–≤–∞–љ–Є–µ), —Н–Ї—Б–њ–ї—Г–∞—В–∞—Ж–Є—О –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є—П (–≤ —В–Њ–Љ —З–Є—Б–ї–µ –Ј–∞—А–∞–±–Њ—В–љ–∞—П –њ–ї–∞—В–∞ –њ–µ—А—Б–Њ–љ–∞–ї–∞), —А–∞–Ј–ї–Є—З–љ—Л–µ –Ї–Њ–Љ–Љ—Г–љ–∞–ї—М–љ—Л–µ —Г—Б–ї—Г–≥–Є (–≤–Ї–ї—О—З–∞—П –∞—А–µ–љ–і—Г –њ–Њ–Љ–µ—Й–µ–љ–Є–є) –Є –њ—А–Є–Њ–±—А–µ—В–µ–љ–Є–µ —А–∞—Б—Е–Њ–і–љ—Л—Е –Љ–∞—В–µ—А–Є–∞–ї–Њ–≤. –°—Е–µ–Љ–∞—В–Є—З–љ–Њ –Є—Е —Б–Њ–Њ—В–љ–Њ—И–µ–љ–Є–µ –њ—А–µ–і—Б—В–∞–≤–ї–µ–љ–Њ –љ–∞ —А–Є—Б—Г–љ–Ї–µ.

–Ъ–∞–Ї –Љ–Њ–ґ–љ–Њ –≤–Є–і–µ—В—М, –Њ—Б–љ–Њ–≤–љ—Г—О –і–Њ–ї—О —Б–Њ—Б—В–∞–≤–ї—П—О—В —А–∞—Б—Е–Њ–і—Л –љ–∞ —Н–ї–µ–Ї—В—А–Њ–њ–Є—В–∞–љ–Є–µ, –Ї–Њ–љ–і–Є—Ж–Є–Њ–љ–Є—А–Њ–≤–∞–љ–Є–µ –Є —Н–Ї—Б–њ–ї—Г–∞—В–∞—Ж–Є—О –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є—П. –Ш—Е —Б–љ–Є–ґ–µ–љ–Є–µ –њ–Њ–Ј–≤–Њ–ї–Є—В –Ї–Њ–Љ–њ–∞–љ–Є—П–Љ –Ј–љ–∞—З–Є—В–µ–ї—М–љ–Њ —Б–Њ–Ї—А–∞—В–Є—В—М —Б–Њ–≤–Њ–Ї—Г–њ–љ—Г—О —Б—В–Њ–Є–Љ–Њ—Б—В—М –≤–ї–∞–і–µ–љ–Є—П (TCO) –¶–Ю–Ф –Є —Г–Љ–µ–љ—М—И–Є—В—М —Б—А–Њ–Ї–Є –≤–Њ–Ј–≤—А–∞—В–∞ –Є–љ–≤–µ—Б—В–Є—Ж–Є–є. –Я–Њ –і–∞–љ–љ—Л–Љ –Њ—А–≥–∞–љ–Є–Ј–∞—Ж–Є–Є Association for Computer Operations Management (AFCOM), –≤ 2009 –≥. –±–Њ–ї–µ–µ 30% –Ї–Њ–Љ–њ–∞–љ–Є–є –њ–ї–∞–љ–Є—А—Г—О—В —Б–Њ–Ї—А–∞—В–Є—В—М –±—О–і–ґ–µ—В—Л –¶–Ю–Ф.

–Ф–ї—П —Б–Њ–Ї—А–∞—Й–µ–љ–Є—П —А–∞—Б—Е–Њ–і–Њ–≤ –њ–Њ—Б—В–∞–≤—Й–Є–Ї–Є —А–µ—И–µ–љ–Є–є –і–ї—П –¶–Ю–Ф –њ—А–µ–і–ї–∞–≥–∞—О—В —Ж–µ–ї—Л–є —А—П–і —В–µ—Е–љ–Њ–ї–Њ–≥–Є–є, –≤–Ї–ї—О—З–∞—П –њ—А–Њ—Ж–µ—Б—Б–Њ—А—Л —Б –њ–Њ–љ–Є–ґ–µ–љ–љ—Л–Љ —Н–љ–µ—А–≥–Њ–њ–Њ—В—А–µ–±–ї–µ–љ–Є–µ–Љ, –±–ї–Њ–Ї–Є –њ–Є—В–∞–љ–Є—П —Б –±–Њ–ї–µ–µ –≤—Л—Б–Њ–Ї–Є–Љ –Ъ–Я–Ф, –∞–і–∞–њ—В–Є–≤–љ–Њ–µ –Њ—Е–ї–∞–ґ–і–µ–љ–Є–µ, –Љ–Њ–і—Г–ї—М–љ—Л–µ —Б–µ—А–≤–µ—А—Л —Б –≥–Є–±–Ї–Є–Љ —Г–њ—А–∞–≤–ї–µ–љ–Є–µ–Љ —Н–љ–µ—А–≥–Њ–њ–Њ—В—А–µ–±–ї–µ–љ–Є–µ–Љ, –≤–Є—А—В—Г–∞–ї–Є–Ј–∞—Ж–Є—О, –∞ —В–∞–Ї–ґ–µ —А—П–і –і—А—Г–≥–Є—Е —А–µ—И–µ–љ–Є–є.

–Ъ—А–Њ–Љ–µ —В–Њ–≥–Њ, –і–ї—П –њ–Њ–≤—Л—И–µ–љ–Є—П —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ—Б—В–Є —Б—Г—Й–µ—Б—В–≤—Г—О—Й–µ–≥–Њ –Є–ї–Є –њ—А–Њ–µ–Ї—В–Є—А—Г–µ–Љ–Њ–≥–Њ –¶–Ю–Ф –≤–µ–љ–і–Њ—А—Л –Є –њ—А–Њ–µ–Ї—В–Є—А–Њ–≤—Й–Є–Ї–Є —Б—В—А–µ–Љ—П—В—Б—П —Б–Њ–Ї—А–∞—В–Є—В—М –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ–≥–Њ –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є—П, –њ–Њ–≤—Л—Б–Є—В—М –Ї–Њ—Н—Д—Д–Є—Ж–Є–µ–љ—В –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—П —Г–ґ–µ —Б—Г—Й–µ—Б—В–≤—Г—О—Й–µ–≥–Њ, –Њ–њ—В–Є–Љ–Є–Ј–Є—А–Њ–≤–∞—В—М –њ–Њ—А—В–Њ–≤—Г—О –µ–Љ–Ї–Њ—Б—В—М, —Г–Љ–µ–љ—М—И–Є—В—М —З–Є—Б–ї–Њ –Ї–∞–±–µ–ї—М–љ—Л—Е —Б–Њ–µ–і–Є–љ–µ–љ–Є–є –Є —Н–ї–µ–Љ–µ–љ—В–Њ–≤ –°–Ъ–° (–Ї–Њ–Љ–Љ—Г—В–∞—Ж–Є–Њ–љ–љ—Л—Е –њ–∞–љ–µ–ї–µ–є, –Њ—А–≥–∞–љ–∞–є–Ј–µ—А–Њ–≤, –ї–Њ—В–Ї–Њ–≤ –Є —В.–њ.).

–Э–Є–ґ–µ —А–µ—З—М –њ–Њ–є–і–µ—В –Њ –љ–Њ–≤–Њ–Љ –і–ї—П —А—Л–љ–Ї–∞ —А–µ—И–µ–љ–Є–Є вАФ —В–µ—Е–љ–Њ–ї–Њ–≥–Є–Є —Г–љ–Є—Д–Є—Ж–Є—А–Њ–≤–∞–љ–љ—Л—Е —Д–∞–±—А–Є–Ї (Unified Fabric), –≤–љ–µ–і—А–µ–љ–Є–µ –Ї–Њ—В–Њ—А–Њ–є –њ–Њ–Ј–≤–Њ–ї—П–µ—В –Ј–љ–∞—З–Є—В–µ–ї—М–љ–Њ —Б–Њ–Ї—А–∞—В–Є—В—М –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ –љ–µ–Њ–±—Е–Њ–і–Є–Љ—Л—Е —Б–µ—В–µ–≤—Л—Е —Г—Б—В—А–Њ–є—Б—В–≤, –∞ —В–∞–Ї–ґ–µ —Б—Г–Љ–Љ–∞—А–љ–Њ–µ —Н–љ–µ—А–≥–Њ–њ–Њ—В—А–µ–±–ї–µ–љ–Є–µ –Є —В–µ–њ–ї–Њ–≤—Л–і–µ–ї–µ–љ–Є–µ –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є—П, –њ–Њ–Љ–Њ–≥–∞–µ—В —Г–њ—А–Њ—Б—В–Є—В—М –Ї–∞–±–µ–ї—М–љ—Г—О —Б–Є—Б—В–µ–Љ—Г, —Б–љ–Є–Ј–Є—В—М –Ј–∞—В—А–∞—В—Л –љ–∞ —Г–њ—А–∞–≤–ї–µ–љ–Є–µ –Є –Љ–Њ–љ–Є—В–Њ—А–Є–љ–≥, —В.–µ. –≤ –Ї–Њ–љ–µ—З–љ–Њ–Љ –Є—В–Њ–≥–µ —Г–Љ–µ–љ—М—И–Є—В—М —Б–Њ–≤–Њ–Ї—Г–њ–љ—Г—О —Б—В–Њ–Є–Љ–Њ—Б—В—М –≤–ї–∞–і–µ–љ–Є—П —В—А–∞–љ—Б–њ–Њ—А—В–љ–Њ–є –Є–љ—Д—А–∞—Б—В—А—Г–Ї—В—Г—А–Њ–є.

–Ю—В–Ї—Г–і–∞ —З—В–Њ –≤–Ј—П–ї–Њ—Б—М

–Т –Ї–ї–∞—Б—Б–Є—З–µ—Б–Ї–Њ–Љ –¶–Ю–Ф –≤ –Ї–∞—З–µ—Б—В–≤–µ —В—А–∞–љ—Б–њ–Њ—А—В–љ–Њ–є –њ–ї–∞—В—Д–Њ—А–Љ—Л, –Ї–∞–Ї –њ—А–∞–≤–Є–ї–Њ, –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В—Б—П –љ–µ—Б–Ї–Њ–ї—М–Ї–Њ –≤–Є–і–Њ–≤ —Б–µ—В–µ–є –і–ї—П –њ–µ—А–µ–і–∞—З–Є —А–∞–Ј–љ—Л—Е –≤–Є–і–Њ–≤ —В—А–∞—Д–Є–Ї–∞. –Ф–ї—П –і–Њ—Б—В–∞–≤–Ї–Є –њ–∞–Ї–µ—В–Њ–≤ IP –њ—А–Є–Љ–µ–љ—П–µ—В—Б—П —В–µ—Е–љ–Њ–ї–Њ–≥–Є—П Ethernet. –°–µ—В—М —Е—А–∞–љ–µ–љ–Є—П –і–∞–љ–љ—Л—Е (SAN) —Д–Є–Ј–Є—З–µ—Б–Ї–Є –Є–Ј–Њ–ї–Є—А–Њ–≤–∞–љ–∞ –Њ—В —Б–µ—В–Є IP, —Б–Њ–і–µ—А–ґ–Є—В —Б–Њ–±—Б—В–≤–µ–љ–љ—Л–µ –Ї–Њ–Љ–Љ—Г—В–∞—В–Њ—А—Л, –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В —Б–њ–µ—Ж–Є–∞–ї—М–љ—Л–µ –њ—А–Њ—В–Њ–Ї–Њ–ї—Л (Fibre Channel Protocol, SCSI) –Є –Њ–±–ї–∞–і–∞–µ—В –Њ—В–і–µ–ї—М–љ–Њ–є –Ї–∞–±–µ–ї—М–љ–Њ–є —Б–Є—Б—В–µ–Љ–Њ–є.

–Т —Б–ї—Г—З–∞–µ –Ї–ї–∞—Б—В–µ—А–љ—Л—Е —А–µ—И–µ–љ–Є–є –і–ї—П –≤–Ј–∞–Є–Љ–Њ–і–µ–є—Б—В–≤–Є—П —Г–Ј–ї–Њ–≤ –Ї–ї–∞—Б—В–µ—А–∞ –љ–µ–Њ–±—Е–Њ–і–Є–Љ–∞ –≤—Л—Б–Њ–Ї–Њ–њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–∞—П —Б—А–µ–і–∞ –њ–µ—А–µ–і–∞—З–Є –і–∞–љ–љ—Л—Е —Б –Љ–∞–ї—Л–Љ–Є –Ј–∞–і–µ—А–ґ–Ї–∞–Љ–Є, –њ–Њ—Н—В–Њ–Љ—Г –≤–Њ–Ј–љ–Є–Ї–∞–µ—В –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ—Б—В—М –≤ –њ–Њ—Б—В—А–Њ–µ–љ–Є–Є –µ—Й–µ –Њ–і–љ–Њ–є —Б–µ—В–Є, –љ–∞–њ—А–Є–Љ–µ—А, —Б –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ–Љ —В–µ—Е–љ–Њ–ї–Њ–≥–Є–Є Infiniband, —Б–њ–µ—Ж–Є–∞–ї–Є–Ј–Є—А–Њ–≤–∞–љ–љ—Л—Е –Ї–Њ–Љ–Љ—Г—В–∞—В–Њ—А–Њ–≤, –Ї–∞–±–µ–ї–µ–є, —А–∞–Ј—К–µ–Љ–Њ–≤ –Є —В.–і. –Т —А–µ–Ј—Г–ї—М—В–∞—В–µ –≤ –¶–Ю–Ф —Б—Г—Й–µ—Б—В–≤—Г—О—В –Ї–∞–Ї –Љ–Є–љ–Є–Љ—Г–Љ —В—А–Є –љ–µ–Ј–∞–≤–Є—Б–Є–Љ—Л–µ —Б–µ—В–Є —Б —Б–Њ–±—Б—В–≤–µ–љ–љ–Њ–є –∞—А—Е–Є—В–µ–Ї—В—Г—А–Њ–є, –њ—А–Њ—В–Њ–Ї–Њ–ї–∞–Љ–Є, –љ–∞–±–Њ—А–Њ–Љ –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є—П –Є –°–Ъ–°. –Ф–ї—П –≤–Ј–∞–Є–Љ–Њ–і–µ–є—Б—В–≤–Є—П —Б –Ї–∞–ґ–і—Л–Љ —В–Є–њ–Њ–Љ —Б–µ—В–Є —Б–µ—А–≤–µ—А—Л –¶–Ю–Ф –і–Њ–ї–ґ–љ—Л –Њ—Б–љ–∞—Й–∞—В—М—Б—П —Б–Њ–Њ—В–≤–µ—В—Б—В–≤—Г—О—Й–Є–Љ –љ–∞–±–Њ—А–Њ–Љ –∞–і–∞–њ—В–µ—А–Њ–≤, –љ–µ–Њ–±—Е–Њ–і–Є–Љ—Л—Е (–†–Є—Б—Г–љ–Њ–Ї 2).

–Э–∞–ї–Є—З–Є–µ –±–Њ–ї—М—И–Њ–≥–Њ —З–Є—Б–ї–∞ –∞–і–∞–њ—В–µ—А–Њ–≤ —А–∞–Ј–љ–Њ–≥–Њ —В–Є–њ–∞, –њ–Њ—В—А–µ–±–љ–Њ—Б—В—М –≤ –Ї–Њ–Љ–Љ—Г—В–∞—Ж–Є–Њ–љ–љ–Њ–Љ –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є–Є –і–ї—П –Ї–∞–ґ–і–Њ–є —Б–µ—В–Є, –Њ–±–Є–ї–Є–µ –Ї–∞–±–µ–ї—М–љ—Л—Е —Б–Њ–µ–і–Є–љ–µ–љ–Є–є –Є —Н–ї–µ–Љ–µ–љ—В–Њ–≤ –°–Ъ–° –њ—А–Є–≤–Њ–і—П—В –Ї –Ј–љ–∞—З–Є—В–µ–ї—М–љ–Њ–Љ—Г —Г—Б–ї–Њ–ґ–љ–µ–љ–Є—О —В—А–∞–љ—Б–њ–Њ—А—В–љ–Њ–є –Є–љ—Д—А–∞—Б—В—А—Г–Ї—В—Г—А—Л –¶–Ю–Ф, –њ–Њ–≤—Л—И–µ–љ–љ–Њ–Љ—Г —Н–љ–µ—А–≥–Њ–њ–Њ—В—А–µ–±–ї–µ–љ–Є—О –Є —В–µ–њ–ї–Њ–≤—Л–і–µ–ї–µ–љ–Є—О, –Ї —В–Њ–Љ—Г –ґ–µ –≤ —Ж–µ–ї—П—Е –Њ–±–µ—Б–њ–µ—З–µ–љ–Є—П –Њ—В–Ї–∞–Ј–Њ—Г—Б—В–Њ–є—З–Є–≤–Њ—Б—В–Є –≤—Б–µ –Ї–ї—О—З–µ–≤—Л–µ —Н–ї–µ–Љ–µ–љ—В—Л —Б–µ—В–µ–≤–Њ–≥–Њ –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є—П –і–Њ–ї–ґ–љ—Л –±—Л—В—М –Ј–∞—А–µ–Ј–µ—А–≤–Є—А–Њ–≤–∞–љ—Л.

–Ш–і–µ—П –Њ–±—К–µ–і–Є–љ–µ–љ–Є—П —А–∞–Ј–ї–Є—З–љ—Л—Е —В–Є–њ–Њ–≤ —Б–µ—В–µ–є –љ–∞ –±–∞–Ј–µ –Њ–і–љ–Њ–≥–Њ –≤–Є–і–∞ —В—А–∞–љ—Б–њ–Њ—А—В–∞ –њ–Њ—П–≤–Є–ї–∞—Б—М –і–Њ—Б—В–∞—В–Њ—З–љ–Њ –і–∞–≤–љ–Њ. –Э–µ–Ї–Њ—В–Њ—А–Њ–µ –≤—А–µ–Љ—П –љ–∞–Ј–∞–і –љ–∞–Є–±–Њ–ї–µ–µ —Б–µ—А—М–µ–Ј–љ—Л–Љ –њ—А–µ—В–µ–љ–і–µ–љ—В–Њ–Љ –љ–∞ —Н—В—Г —А–Њ–ї—М —Б—З–Є—В–∞–ї–∞—Б—М —В–µ—Е–љ–Њ–ї–Њ–≥–Є—П Infiniband, –љ–Њ —И–Є—А–Њ–Ї–Њ–≥–Њ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ–µ–љ–Є—П –Њ–љ–∞ –љ–µ –њ–Њ–ї—Г—З–Є–ї–∞ –Є –≤ –љ–∞—Б—В–Њ—П—Й–Є–є –Љ–Њ–Љ–µ–љ—В –Є–≥—А–∞–µ—В —А–Њ–ї—М –љ–Є—И–µ–≤–Њ–≥–Њ, —Г–Ј–Ї–Њ—Б–њ–µ—Ж–Є–∞–ї–Є–Ј–Є—А–Њ–≤–∞–љ–љ–Њ–≥–Њ —А–µ—И–µ–љ–Є—П. –Т –Ї–∞—З–µ—Б—В–≤–µ —Г–љ–Є—Д–Є—Ж–Є—А–Њ–≤–∞–љ–љ–Њ–≥–Њ –њ—А–Њ—В–Њ–Ї–Њ–ї–∞ –і–ї—П –њ–µ—А–µ–і–∞—З–Є —А–∞–Ј–ї–Є—З–љ—Л—Е —В–Є–њ–Њ–≤ —В—А–∞—Д–Є–Ї–∞ —А–∞—Б—Б–Љ–∞—В—А–Є–≤–∞–ї—Б—П –і–∞–ґ–µ –њ—А–Њ—В–Њ–Ї–Њ–ї FibreChannel (FC), –Ї–Њ—В–Њ—А—Л–є –љ–∞ –≤–µ—А—Е–љ–µ–Љ —Г—А–Њ–≤–љ–µ —Б–њ–Њ—Б–Њ–±–µ–љ –њ–Њ–Љ–Є–Љ–Њ —Б—В–∞–љ–і–∞—А—В–љ—Л—Е –±–ї–Њ–Ї–Њ–≤ SCSI –њ–µ—А–µ–љ–Њ—Б–Є—В—М –Є –њ–∞–Ї–µ—В—Л IP. –Э–Њ –µ–≥–Њ –њ–Њ–≤—Б–µ–Љ–µ—Б—В–љ–Њ–Љ—Г –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—О –њ—А–µ–њ—П—В—Б—В–≤—Г–µ—В —А—П–і –Њ—Б–Њ–±–µ–љ–љ–Њ—Б—В–µ–є вАФ –≤—Л—Б–Њ–Ї–∞—П —Б—В–Њ–Є–Љ–Њ—Б—В—М —Б–њ–µ—Ж–Є–∞–ї–Є–Ј–Є—А–Њ–≤–∞–љ–љ–Њ–≥–Њ –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є—П, –Њ–≥—А–∞–љ–Є—З–µ–љ–Є—П –љ–∞ –њ—А–Њ—В—П–ґ–µ–љ–љ–Њ—Б—В—М —Б–µ—В–Є, –Є–Ј–ї–Є—И–љ–Є–µ —Н–Ї—Б–њ–ї—Г–∞—В–∞—Ж–Є–Њ–љ–љ—Л–µ –Ј–∞—В—А–∞—В—Л.

–Э–∞–Є–±–Њ–ї–µ–µ —А–µ–∞–ї—М–љ—Л–Љ –њ—А–µ—В–µ–љ–і–µ–љ—В–Њ–Љ —П–≤–ї—П–ї–∞—Б—М —В–µ—Е–љ–Њ–ї–Њ–≥–Є—П iSCSI, –≤ —Б–Њ–Њ—В–≤–µ—В—Б—В–≤–Є–Є —Б –Ї–Њ—В–Њ—А–Њ–є –±–ї–Њ–Ї–Є –њ—А–Њ—В–Њ–Ї–Њ–ї–∞ SCSI –њ–µ—А–µ–і–∞—О—В—Б—П –њ–Њ –њ—А–Њ—В–Њ–Ї–Њ–ї—Г TCP/IP –њ–Њ —Г–ґ–µ –њ–Њ—Б—В—А–Њ–µ–љ–љ–Њ–є –Є–љ—Д—А–∞—Б—В—А—Г–Ї—В—Г—А–µ IP. –Э–Њ –њ–Њ–Љ–Є–Љ–Њ –њ—А–µ–Є–Љ—Г—Й–µ—Б—В–≤ iSCSI –Є–Љ–µ–µ—В –љ–µ–Љ–∞–ї–Њ –љ–µ–і–Њ—Б—В–∞—В–Ї–Њ–≤: –љ–µ–њ—А–µ–і—Б–Ї–∞–Ј—Г–µ–Љ—Г—О (–Є –Ј–љ–∞—З–Є—В–µ–ї—М–љ—Г—О –њ–Њ –Љ–µ—А–Ї–∞–Љ —Б–µ—В–Є —Е—А–∞–љ–µ–љ–Є—П) –Ј–∞–і–µ—А–ґ–Ї—Г; –љ–µ–≤—Л—Б–Њ–Ї—Г—О —Б–Ї–Њ—А–Њ—Б—В—М –њ–µ—А–µ–і–∞—З–Є –і–∞–љ–љ—Л—Е –≤—Б–ї–µ–і—Б—В–≤–Є–µ –Њ—Б–Њ–±–µ–љ–љ–Њ—Б—В–µ–є —Д—Г–љ–Ї—Ж–Є–Њ–љ–Є—А–Њ–≤–∞–љ–Є—П –њ—А–Њ—В–Њ–Ї–Њ–ї–Њ–≤ —Б—В–µ–Ї–∞ TCP/IP; —Г–≤–µ–ї–Є—З–µ–љ–Є–µ –љ–∞–≥—А—Г–Ј–Ї–Є –љ–∞ —Ж–µ–љ—В—А–∞–ї—М–љ—Л–µ –њ—А–Њ—Ж–µ—Б—Б–Њ—А—Л —Б–µ—А–≤–µ—А–Њ–≤ (–њ—А–Є —Н—В–Њ–Љ –≤—Л—З–Є—Б–ї–Є—В–µ–ї—М–љ—Л–µ —А–µ—Б—Г—А—Б—Л –Њ—В–±–Є—А–∞—О—В—Б—П —Г –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—М—Б–Ї–Є—Е –њ—А–Є–ї–Њ–ґ–µ–љ–Є–є); —Б–љ–Є–ґ–µ–љ–Є–µ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є —Б—Г—Й–µ—Б—В–≤—Г—О—Й–µ–є –Є–љ—Д—А–∞—Б—В—А—Г–Ї—В—Г—А—Л IP –≤ —А–µ–Ј—Г–ї—М—В–∞—В–µ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—П —З–∞—Б—В–Є –њ—А–Њ–њ—Г—Б–Ї–љ–Њ–є —Б–њ–Њ—Б–Њ–±–љ–Њ—Б—В–Є —Б–µ—В–Є –і–ї—П –њ–µ—А–µ–і–∞—З–Є —В—А–∞—Д–Є–Ї–∞ —Б–µ—В–Є —Е—А–∞–љ–µ–љ–Є—П; –њ—А–Њ–±–ї–µ–Љ—Л —Б –Њ–±–µ—Б–њ–µ—З–µ–љ–Є–µ–Љ –±–µ–Ј–Њ–њ–∞—Б–љ–Њ—Б—В–Є –њ–µ—А–µ–і–∞–≤–∞–µ–Љ–Њ–≥–Њ —В—А–∞—Д–Є–Ї–∞.

–Т–∞—А–Є–∞—Ж–Є–Є –љ–∞ —В–µ–Љ—Г Ethernet

–Я–Њ–≤—Б–µ–Љ–µ—Б—В–љ–Њ–µ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–µ —В–µ—Е–љ–Њ–ї–Њ–≥–Є–Є Ethernet –≤ –ї–Њ–Ї–∞–ї—М–љ—Л—Е —Б–µ—В—П—Е —Ж–µ–љ—В—А–Њ–≤ –Њ–±—А–∞–±–Њ—В–Ї–Є –і–∞–љ–љ—Л—Е, –µ–µ –∞–Ї—В–Є–≤–љ–Њ–µ —А–∞–Ј–≤–Є—В–Є–µ –≤ –њ–ї–∞–љ–µ –Љ–∞—Б—И—В–∞–±–Є—А–Њ–≤–∞–љ–Є—П —Б–Ї–Њ—А–Њ—Б—В–µ–є (—Б–µ–≥–Њ–і–љ—П –≤ –¶–Ю–Ф –і–ї—П –њ–Њ—Б—В—А–Њ–µ–љ–Є—П –≤—Л—Б–Њ–Ї–Њ—Б–Ї–Њ—А–Њ—Б—В–љ—Л—Е –Љ–∞–≥–Є—Б—В—А–∞–ї–µ–є —И–Є—А–Њ–Ї–Њ –њ—А–Є–Љ–µ–љ—П–µ—В—Б—П —В–µ—Е–љ–Њ–ї–Њ–≥–Є—П 10GE), –њ–Њ—П–≤–ї–µ–љ–Є–µ –≤ –±–ї–Є–ґ–∞–є—И–µ–Љ –±—Г–і—Г—Й–µ–Љ —В–µ—Е–љ–Њ–ї–Њ–≥–Є–є 40GE/100GE, –∞ –≤ –њ–µ—А—Б–њ–µ–Ї—В–Є–≤–µ –Є —В–µ—А–∞–±–Є—В–Њ–≤—Л—Е —Б–Ї–Њ—А–Њ—Б—В–µ–є, —Г—Б–њ–µ—И–љ–Њ–µ –Є—Б–њ—Л—В–∞–љ–Є–µ –≤—А–µ–Љ–µ–љ–µ–Љ –Є –Љ–љ–Њ–ґ–µ—Б—В–≤–Њ —Е–Њ—А–Њ—И–Њ –њ–Њ–і–≥–Њ—В–Њ–≤–ї–µ–љ–љ—Л—Е –≤ —Н—В–Њ–є –Њ–±–ї–∞—Б—В–Є —Б–њ–µ—Ж–Є–∞–ї–Є—Б—В–Њ–≤ –Ш–Ґ –Ј–∞—Б—В–∞–≤–ї—П—О—В –Љ–Є—А–Њ–≤–Њ–µ –Ш–Ґ-—Б–Њ–Њ–±—Й–µ—Б—В–≤–Њ –њ–Њ-–љ–Њ–≤–Њ–Љ—Г –≤–Ј–≥–ї—П–љ—Г—В—М –љ–∞ –±—Г–і—Г—Й–µ–µ Ethernet.

–Ц–µ–ї–∞–љ–Є–µ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї–µ–є –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є—П –Њ–±—К–µ–і–Є–љ–Є—В—М –ї—Г—З—И–Є–µ –Ї–∞—З–µ—Б—В–≤–∞ —Г–њ–Њ–Љ—П–љ—Г—В—Л—Е –≤—Л—И–µ –њ—А–Њ—В–Њ–Ї–Њ–ї–Њ–≤ –њ—А–Є–≤–µ–ї–Є –Ї –њ–Њ—П–≤–ї–µ–љ–Є—О —В–µ—Е–љ–Њ–ї–Њ–≥–Є–Є –њ–Њ–і –љ–∞–Ј–≤–∞–љ–Є–µ–Љ Fibre Channel –њ–Њ–≤–µ—А—Е Ethernet (F–°oE). –Ю–љ–∞ —А–∞–Ј—А–∞–±–∞—В—Л–≤–∞–ї–∞—Б—М –њ–Њ–і —Н–≥–Є–і–Њ–є –Ї–Њ–Љ–Є—В–µ—В–∞ INCITS T11 –Є –њ—А–µ–і—Б—В–∞–≤–ї—П–µ—В —Б–Њ–±–Њ–є —Б—В–∞–љ–і–∞—А—В –њ–µ—А–µ–і–∞—З–Є –Ї–∞–і—А–Њ–≤ Fibre Channel —З–µ—А–µ–Ј —Б–µ—В—М Ethernet. –Ф–ї—П –Њ—Б—Г—Й–µ—Б—В–≤–ї–µ–љ–Є—П –њ–µ—А–µ–і–∞—З–Є —В—А–∞—Д–Є–Ї–∞ Fibre Channel —З–µ—А–µ–Ј —Б–µ—В—М, –њ–Њ—Б—В—А–Њ–µ–љ–љ—Г—О –љ–∞ –±–∞–Ј–µ Ethernet, –Ї–∞–і—А FC, –≤–Ї–ї—О—З–∞—П –Ј–∞–≥–Њ–ї–Њ–≤–Њ–Ї, –Є–љ–Ї–∞–њ—Б—Г–ї–Є—А—Г–µ—В—Б—П –≤ –Ї–∞–і—А Ethernet –љ–∞ —Б—В–Њ—А–Њ–љ–µ –њ–µ—А–µ–і–∞—О—Й–µ–≥–Њ —Г—Б—В—А–Њ–є—Б—В–≤–∞ –Є –Њ—В–њ—А–∞–≤–ї—П–µ—В—Б—П –њ–Њ–ї—Г—З–∞—В–µ–ї—О, –Ї–Њ—В–Њ—А—Л–є –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В –і–µ–Є–љ–Ї–∞–њ—Б—Г–ї—П—Ж–Є—О –Є—Б—Е–Њ–і–љ–Њ–≥–Њ –Ї–∞–і—А–∞ FC –Є –µ–≥–Њ –њ–Њ—Б–ї–µ–і—Г—О—Й—Г—О –Њ–±—А–∞–±–Њ—В–Ї—Г.

–Ґ–∞–Ї–Є–Љ –Њ–±—А–∞–Ј–Њ–Љ, —Б —В–Њ—З–Ї–Є –Ј—А–µ–љ–Є—П —В–µ—Е–љ–Њ-–ї–Њ–≥–Є–Є Ethernet —Н—В–Њ –≤—Л–≥–ї—П–і–Є—В –Ї–∞–Ї –њ–µ—А–µ–і–∞—З–∞ –µ—Й–µ –Њ–і–љ–Њ–≥–Њ —В–Є–њ–∞ –њ—А–Њ—В–Њ–Ї–Њ–ї–∞ –≤–µ—А—Е–љ–µ–≥–Њ —Г—А–Њ–≤–љ—П (Fibre Channel) –њ–Њ–≤–µ—А—Е —Б—Г—Й–µ—Б—В–≤—Г—О—Й–µ–є –Є–љ—Д—А–∞—Б—В—А—Г–Ї—В—Г—А—Л (Ethernet), –∞ –і–ї—П —В—А–∞–љ—Б–њ–Њ—А—В–Є—А—Г–µ–Љ–Њ–≥–Њ –њ—А–Њ—В–Њ–Ї–Њ–ї–∞ Ethernet —П–≤–ї—П–µ—В—Б—П –њ—А–Њ–Ј—А–∞—З–љ–Њ–є —Б—А–µ–і–Њ–є –њ–µ—А–µ–і–∞—З–Є –Њ—А–Є–≥–Є–љ–∞–ї—М–љ—Л—Е –Ї–∞–і—А–Њ–≤ Fibre Channel. –£—Б—В—А–Њ–є—Б—В–≤–∞ —Б –њ–Њ–і–і–µ—А–ґ–Ї–Њ–є FC (—Б–µ—А–≤–µ—А—Л, –і–Є—Б–Ї–Њ–≤—Л–µ –Љ–∞—Б—Б–Є–≤—Л) –≤–Є–і—П—В –і—А—Г–≥ –і—А—Г–≥–∞ —В–∞–Ї, –Ї–∞–Ї –µ—Б–ї–Є –±—Л –Њ–љ–Є –љ–∞—Е–Њ–і–Є–ї–Є—Б—М –≤ –µ–і–Є–љ–Њ–є —Б—В–∞–љ–і–∞—А—В–љ–Њ–є —Б–µ—В–Є Fibre Channel, –њ—А–Є —Н—В–Њ–Љ –њ–Њ–ї–љ–Њ—Б—В—М—О —Б–Њ—Е—А–∞–љ—П—О—В—Б—П –Є–і–µ–Њ–ї–Њ–≥–Є—П –Є –Љ–Њ–і–µ–ї—М —Г–њ—А–∞–≤–ї–µ–љ–Є—П –Њ—А–Є–≥–Є–љ–∞–ї—М–љ–Њ–≥–Њ FC, –≤–Ї–ї—О—З–∞—П —Б—Е–µ–Љ—Г –∞–і—А–µ—Б–∞—Ж–Є–Є, —Б–ї—Г–ґ–±—Л, –њ—А–Њ—Ж–µ—Б—Б—Л –Є —Б–µ—А–≤–Є—Б—Л вАФ FLOGI, Name Server, LUN Zoning, LUN Masking, VSAN –Є —В.–і. –§–Њ—А–Љ–∞—В –Ї–∞–і—А–∞ FCoE –њ—А–Є–≤–µ–і–µ–љ –љ–∞ –†–Є—Б—Г–љ–Ї–µ 3.

FCoE –њ—А–µ–і—К—П–≤–ї—П–µ—В –Ї –Ї–Њ–Љ–Љ—Г—В–Є—А—Г—О—Й–µ–є –Є–љ—Д—А–∞—Б—В—А—Г–Ї—В—Г—А–µ –і–≤–∞ –Њ—Б–љ–Њ–≤–љ—Л—Е —В—А–µ–±–Њ–≤–∞–љ–Є—П: –њ–Њ–і–і–µ—А–ґ–Ї–∞ –Ї–∞–і—А–Њ–≤ –±–Њ–ї—М—И–Њ–≥–Њ —А–∞–Ј–Љ–µ—А–∞ (—В–∞–Ї –љ–∞–Ј—Л–≤–∞–µ–Љ—Л–µ Jumbo Frame) –Є –љ–∞–ї–Є—З–Є–µ –≤—Л—Б–Њ–Ї–Њ—Б–Ї–Њ—А–Њ—Б—В–љ—Л—Е —Б–Њ–µ–і–Є–љ–µ–љ–Є–є (–Њ—В 10 –У–±–Є—В/—Б). –≠—В–Њ –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ –і–ї—П —В–Њ–≥–Њ, —З—В–Њ–±—Л –Ї–∞–і—А FC —А–∞–Ј–Љ–µ—А–Њ–Љ 2112 –±–∞–є—В –Љ–Њ–ґ–љ–Њ –±—Л–ї–Њ —Ж–µ–ї–Є–Ї–Њ–Љ —Г–њ–∞–Ї–Њ–≤–∞—В—М –≤ –Ї–∞–і—А Ethernet –±–µ–Ј –і–µ—Д—А–∞–≥–Љ–µ–љ—В–∞—Ж–Є–Є, –∞ —В–∞–Ї–ґ–µ –Њ–±–µ—Б–њ–µ—З–Є—В—М –±–Њ–ї—М—И—Г—О –∞–≥—А–µ–≥–Є—А–Њ–≤–∞–љ–љ—Г—О —Б–Ї–Њ—А–Њ—Б—В—М –і–ї—П —А–∞–Ј–ї–Є—З–љ—Л—Е —В–Є–њ–Њ–≤ —В—А–∞—Д–Є–Ї–∞, –њ–µ—А–µ–і–∞–≤–∞–µ–Љ–Њ–≥–Њ –њ–Њ–≤–µ—А—Е Ethernet.

–Ґ–µ—Е–љ–Њ–ї–Њ–≥–Є—П FCoE –њ–Њ–ї—Г—З–Є–ї–∞ —И–Є—А–Њ–Ї—Г—О –њ–Њ–і–і–µ—А–ґ–Ї—Г —Б–Њ —Б—В–Њ—А–Њ–љ—Л –≤–µ–і—Г—Й–Є—Е –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї–µ–є –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є—П –і–ї—П —Б–µ—В–µ–є —Е—А–∞–љ–µ–љ–Є—П: Cisco Systems, Emulex, Brocade, EMC, IBM, Intel –Є Sun Microsystems. –Ъ–∞–Ј–∞–ї–Њ—Б—М –±—Л, –≤—Л—Е–Њ–і –љ–∞–є–і–µ–љ вАУ Ethernet –Љ–Њ–ґ–љ–Њ –њ—А–Є–Љ–µ–љ—П—В—М –≤ –Ї–∞—З–µ—Б—В–≤–µ —Г–љ–Є—Д–Є—Ж–Є—А–Њ–≤–∞–љ–љ–Њ–≥–Њ —В—А–∞–љ—Б–њ–Њ—А—В–∞ –¶–Ю–Ф, —Г—З–Є—В—Л–≤–∞—П –µ–≥–Њ —Б–Ї–Њ—А–Њ—Б—В–љ—Л–µ —Е–∞—А–∞–Ї—В–µ—А–Є—Б—В–Є–Ї–Є –Є –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М –њ–µ—А–µ–љ–Њ—Б–Є—В—М –Ї–∞–і—А—Л FC (c –њ–Њ–Љ–Њ—Й—М—О –њ—А–Њ—В–Њ–Ї–Њ–ї–∞ FCoE) –±–µ–Ј –Є–љ–Ї–∞–њ—Б—Г–ї—П—Ж–Є–Є –њ—А–Њ—В–Њ–Ї–Њ–ї–Њ–≤ —Б—В–µ–Ї–∞ TCP/IP –Є –і–Њ–њ–Њ–ї–љ–Є—В–µ–ї—М–љ—Л—Е —А–∞—Б—Е–Њ–і–Њ–≤ –љ–∞ –њ–µ—А–µ–і–∞—З—Г –±–Њ–ї—М—И–Њ–≥–Њ –Ї–Њ–ї–Є—З–µ—Б—В–≤–∞ —Б–ї—Г–ґ–µ–±–љ—Л—Е –Ј–∞–≥–Њ–ї–Њ–≤–Ї–Њ–≤, –Ї–∞–Ї —Н—В–Њ, –љ–∞–њ—А–Є–Љ–µ—А, –њ—А–Њ–Є—Б—Е–Њ–і–Є—В –њ—А–Є –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–Є —В–µ—Е–љ–Њ–ї–Њ–≥–Є–Є FCIP. –Э–Њ –љ–µ –≤—Б–µ —В–∞–Ї –њ—А–Њ—Б—В–Њ.

–Т –Ї–ї–∞—Б—Б–Є—З–µ—Б–Ї–Њ–є –≤–µ—А—Б–Є–Є Ethernet —Б—Г—Й–µ—Б—В–≤—Г–µ—В —А—П–і –љ–µ–і–Њ—Б—В–∞—В–Ї–Њ–≤, –Є–Ј-–Ј–∞ –Ї–Њ—В–Њ—А—Л—Е —Н—В–∞ —В–µ—Е–љ–Њ–ї–Њ–≥–Є—П –љ–µ –њ—А–Є–≥–Њ–і–љ–∞ –і–ї—П –њ–µ—А–µ–і–∞—З–Є –Ї—А–Є—В–Є—З–љ–Њ–≥–Њ –Ї –њ–Њ—В–µ—А—П–Љ —В—А–∞—Д–Є–Ї–∞, –≤ —З–∞—Б—В–љ–Њ—Б—В–Є, —В—А–∞—Д–Є–Ї–∞ —Б–µ—В–µ–є —Е—А–∞–љ–µ–љ–Є—П. –Ю—З–µ–≤–Є–і–љ–Њ, —З—В–Њ –≤ —Б—Г—Й–µ—Б—В–≤—Г—О—Й–µ–Љ –≤–Є–і–µ Ethernet –љ–µ –Љ–Њ–ґ–µ—В –Є–≥—А–∞—В—М —А–Њ–ї—М –љ–∞–і–µ–ґ–љ–Њ–≥–Њ —В—А–∞–љ—Б–њ–Њ—А—В–∞ –Ї–∞–љ–∞–ї—М–љ–Њ–≥–Њ —Г—А–Њ–≤–љ—П, –і–ї—П —Н—В–Њ–≥–Њ –µ–µ –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ –Њ–њ—А–µ–і–µ–ї–µ–љ–љ—Л–Љ –Њ–±—А–∞–Ј–Њ–Љ –і–Њ—А–∞–±–Њ—В–∞—В—М.

Ethernet –і–ї—П –¶–Ю–Ф

–Э–∞–і –≤–Њ–њ—А–Њ—Б–Њ–Љ —Г—Б–Њ–≤–µ—А—И–µ–љ—Б—В–≤–Њ–≤–∞–љ–Є—П —В—А–∞–і–Є—Ж–Є–Њ–љ–љ–Њ–≥–Њ –њ—А–Њ—В–Њ–Ї–Њ–ї–∞ Ethernet –љ–∞ –њ—А–Њ—В—П–ґ–µ–љ–Є–Є —А—П–і–∞ –ї–µ—В —А–∞–±–Њ—В–∞–ї–Є –љ–µ—Б–Ї–Њ–ї—М–Ї–Њ –Њ—А–≥–∞–љ–Є–Ј–∞—Ж–Є–є. –Ш—В–Њ–≥–Њ–Љ –Є—Е —В—А—Г–і–∞ —Б—В–∞–ї –љ–∞–±–Њ—А —Г—Б–Њ–≤–µ—А—И–µ–љ—Б—В–≤–Њ–≤–∞–љ–Є–є, –њ–Њ–ї—Г—З–Є–≤—И–Є—Е –љ–∞–Ј–≤–∞–љ–Є–µ Converged Enhanced Ethernet (CEE), Data Center Bridging (DCB) –Є Cisco Data Center Ethernet (DCE). –Т –Є—Е –Њ—Б–љ–Њ–≤–µ –ї–µ–ґ–∞—В –Њ–і–љ–Є –Є —В–µ –ґ–µ –±–∞–Ј–Њ–≤—Л–µ —Б–њ–µ—Ж–Є—Д–Є–Ї–∞—Ж–Є–Є, –њ–Њ—Н—В–Њ–Љ—Г –≤ –Њ–њ—А–µ–і–µ–ї–µ–љ–љ–Њ–є —Б—В–µ–њ–µ–љ–Є —Н—В–Є —В–µ—А–Љ–Є–љ—Л –Љ–Њ–ґ–љ–Њ —Б—З–Є—В–∞—В—М —Б–Є–љ–Њ–љ–Є–Љ–∞–Љ–Є. –Т–Љ–µ—Б—В–µ —Б —В–µ–Љ –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ —Г—З–Є—В—Л–≤–∞—В—М, —З—В–Њ DCE —Б–Њ–і–µ—А–ґ–Є—В —А–∞—Б—И–Є—А–µ–љ–љ—Л–є –љ–∞–±–Њ—А –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–µ–є –њ–Њ —Б—А–∞–≤–љ–µ–љ–Є—О —Б CEE/DCB.

–Э–∞–Є–±–Њ–ї–µ–µ –Ї–Њ—А—А–µ–Ї—В–љ–Њ–µ –Њ–њ—А–µ–і–µ–ї–µ–љ–Є–µ Data Center Ethernet –±—Г–і–µ—В –≤—Л–≥–ї—П–і–µ—В—М —В–∞–Ї: DCE –њ—А–µ–і—Б—В–∞–≤–ї—П–µ—В —Б–Њ–±–Њ–є –∞—А—Е–Є—В–µ–Ї—В—Г—А—Г –љ–∞ –±–∞–Ј–µ –љ–∞–±–Њ—А–∞ –Њ—В–Ї—А—Л—В—Л—Е —Б—В–∞–љ–і–∞—А—В–Њ–≤ —А–∞—Б—И–Є—А–µ–љ–Є–є Ethernet, –Ї–Њ—В–Њ—А–∞—П –њ—А–µ–і–љ–∞–Ј–љ–∞—З–µ–љ–∞ –і–ї—П —Г–ї—Г—З—И–µ–љ–Є—П –Є —А–∞—Б—И–Є—А–µ–љ–Є—П —Д—Г–љ–Ї—Ж–Є–Њ–љ–∞–ї–∞ –Ї–ї–∞—Б—Б–Є—З–µ—Б–Ї–Њ–≥–Њ Ethernet –≤ —Б–Њ–Њ—В–≤–µ—В—Б—В–≤–Є–Є —Б —В—А–µ–±–Њ–≤–∞–љ–Є—П–Љ–Є, –њ—А–µ–і—К—П–≤–ї—П–µ–Љ—Л–Љ–Є –Ї Ethernet –Ї–∞–Ї –Ї –Ї–Њ–љ–≤–µ—А–≥–µ–љ—В–љ–Њ–Љ—Г —В—А–∞–љ—Б–њ–Њ—А—В—Г —Б–Њ–≤—А–µ–Љ–µ–љ–љ–Њ–≥–Њ –¶–Ю–Ф.

DCE –≤–Ї–ї—О—З–∞–µ—В –≤ —Б–µ–±—П –і–≤–∞ –Њ—Б–љ–Њ–≤–љ—Л—Е –Ї–Њ–Љ–њ–Њ–љ–µ–љ—В–∞: —Б–Њ–±—Б—В–≤–µ–љ–љ–Њ –љ–∞–±–Њ—А —А–∞—Б—И–Є—А–µ–љ–Є–є Ethernet –Є –∞–њ–њ–∞—А–∞—В–љ—Л–µ —Б—А–µ–і—Б—В–≤–∞, –Њ–±–µ—Б–њ–µ—З–Є–≤–∞—О—Й–Є–µ –≤–љ—Г—В—А–µ–љ–љ—О—О –њ–µ—А–µ–і–∞—З—Г —В—А–∞—Д–Є–Ї–∞ –±–µ–Ј –њ–Њ—В–µ—А—М (—В–∞–Ї –љ–∞–Ј—Л–≤–∞–µ–Љ—Л–є Lossless Ethernet Switch Fabric). –Э–∞–±–Њ—А —А–∞—Б—И–Є—А–µ–љ–Є–є DCE —Б–Њ–і–µ—А–ґ–Є—В –Ї–∞–Ї –Њ–±—П–Ј–∞—В–µ–ї—М–љ—Л–є, —В–∞–Ї –Є –Њ–њ—Ж–Є–Њ–љ–∞–ї—М–љ—Л–є —Д—Г–љ–Ї—Ж–Є–Њ–љ–∞–ї.

–Ъ –Њ–±—П–Ј–∞—В–µ–ї—М–љ–Њ–Љ—Г —Д—Г–љ–Ї—Ж–Є–Њ–љ–∞–ї—Г –Њ—В–љ–Њ—Б—П—В—Б—П —Б–ї–µ–і—Г—О—Й–Є–µ —А–∞—Б—И–Є—А–µ–љ–Є—П:

- –Љ–µ—Е–∞–љ–Є–Ј–Љ —Г–њ—А–∞–≤–ї–µ–љ–Є—П –њ–Њ—В–Њ–Ї–Њ–Љ –љ–∞ –Њ—Б–љ–Њ–≤–µ –њ—А–Є–Њ—А–Є—В–µ—В–Њ–≤ (Priority-based Flow Control, PFC). PFC —А–∞—Б—И–Є—А—П–µ—В —Д—Г–љ–Ї—Ж–Є–Њ–љ–∞–ї —Б—В–∞–љ–і–∞—А—В–љ–Њ–≥–Њ –Љ–µ—Е–∞–љ–Є–Ј–Љ–∞ PAUSE (–Њ–њ–Є—Б–∞–љ–љ–Њ–≥–Њ –≤ —Б—В–∞–љ–і–∞—А—В–µ IEEE 802.3x). –Х—Б–ї–Є –Љ–µ—Е–∞–љ–Є–Ј–Љ PAUSE –≤—Л–Ј—Л–≤–∞–µ—В –њ—А–µ–Ї—А–∞—Й–µ–љ–Є–µ –њ–µ—А–µ–і–∞—З–Є –≤—Б–µ–≥–Њ —В—А–∞—Д–Є–Ї–∞ –њ–Њ –Ї–∞–љ–∞–ї—Г Ethernet, —В–Њ –Љ–µ—Е–∞–љ–Є–Ј–Љ PFC —А–∞–Ј–і–µ–ї—П–µ—В –µ–≥–Њ –љ–∞ –≤–Њ—Б–µ–Љ—М –≤–Є—А—В—Г–∞–ї—М–љ—Л—Е –њ–Њ–ї–Њ—Б (virtual lane) –Є –њ–Њ–Ј–≤–Њ–ї—П–µ—В —Г–њ—А–∞–≤–ї—П—В—М –њ–µ—А–µ–і–∞—З–µ–є —В—А–∞—Д–Є–Ї–∞ –љ–∞ –Њ—Б–љ–Њ–≤–µ –њ—А–Є–Њ—А–Є—В–µ—В–Њ–≤ —А–∞–Ј–і–µ–ї—М–љ–Њ –і–ї—П –Ї–∞–ґ–і–Њ–є –ї–Є–љ–Є–Є. –Ґ–∞–Ї–Є–Љ –Њ–±—А–∞–Ј–Њ–Љ –Љ–Њ–ґ–љ–Њ —Б–Њ–Ј–і–∞—В—М –ї–Є–љ–Є—О –±–µ–Ј –њ–Њ—В–µ—А—М (lossless lane) –і–ї—П —З—Г–≤—Б—В–≤–Є—В–µ–ї—М–љ–Њ–≥–Њ –Ї –њ–Њ—В–µ—А—П–Љ —В—А–∞—Д–Є–Ї–∞ (—В–∞–Ї–Њ–≥–Њ –Ї–∞–Ї Fibre Channel) –Є –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М –Њ—Б—В–∞–ї—М–љ—Л–µ –ї–Є–љ–Є–Є –≤ —Б—В–∞–љ–і–∞—А—В–љ–Њ–Љ —А–µ–ґ–Є–Љ–µ —Б–±—А–Њ—Б–∞ –њ–∞–Ї–µ—В–Њ–≤ –і–ї—П –Њ–±—Л—З–љ–Њ–≥–Њ —В—А–∞—Д–Є–Ї–∞ IP. –Ь–µ—Е–∞–љ–Є–Ј–Љ Priority-based Flow Control –Њ–њ–Є—Б–∞–љ –≤ —Б—В–∞–љ–і–∞—А—В–µ IEEE 802.1Qbb;

- Enhanced Transmission Selection (ETS) –Њ–±–µ—Б–њ–µ—З–Є–≤–∞–µ—В —Г–њ—А–∞–≤–ї–µ–љ–Є–µ —А–∞–Ј–і–µ–ї–µ–љ–Є–µ–Љ –њ—А–Њ–њ—Г—Б–Ї–љ–Њ–є —Б–њ–Њ—Б–Њ–±–љ–Њ—Б—В–Є –Ї–Њ–љ—Б–Њ–ї–Є–і–Є—А–Њ–≤–∞–љ–љ–Њ–≥–Њ –Ї–∞–љ–∞–ї–∞ –і–ї—П —А–∞–Ј–љ—Л—Е —В–Є–њ–Њ–≤ –ї–Є–љ–Є–є, —А–µ—И–∞—П –Ј–∞–і–∞—З—Г —Б–Њ–≤–Љ–µ—Б—В–љ–Њ–є –њ–µ—А–µ–і–∞—З–Є —А–∞–Ј–љ—Л—Е —В–Є–њ–Њ–≤ —В—А–∞—Д–Є–Ї–∞ –±–µ–Ј —Г—Й–µ—А–±–∞ –і–ї—П –Ї–∞—З–µ—Б—В–≤–∞. –≠—В–Њ—В –Є–љ—Б—В—А—Г–Љ–µ–љ—В –Њ–њ–Є—Б–∞–љ –≤ —Б—В–∞–љ–і–∞—А—В–µ IEEE 802.1Qaz;

- Data Center Bridging eXchange (DCBX) –Њ—В–≤–µ—З–∞–µ—В –Ј–∞ –Њ–±–љ–∞—А—Г–ґ–µ–љ–Є–µ –Є –∞–≤—В–Њ–Љ–∞—В–Є—З–µ—Б–Ї–Њ–µ —Б–Њ–≥–ї–∞—Б–Њ–≤–∞–љ–Є–µ —А—П–і–∞ –њ–∞—А–∞–Љ–µ—В—А–Њ–≤, –≤–Ї–ї—О—З–∞—П —Г–њ—А–∞–≤–ї–µ–љ–Є–µ –њ–Њ–ї–Њ—Б–Њ–є –Є –њ–Њ—В–Њ–Ї–Њ–Љ –њ–Њ –Ї–ї–∞—Б—Б–∞–Љ, –∞ —В–∞–Ї–ґ–µ —Г–њ—А–∞–≤–ї–µ–љ–Є–µ –њ–µ—А–µ–≥—А—Г–Ј–Ї–∞–Љ–Є –Є –ї–Њ–≥–Є—З–µ—Б–Ї–Є–Љ —Б–Њ—Б—В–Њ—П–љ–Є–µ–Љ –њ–Њ–ї–Њ—Б. –Ъ—А–Њ–Љ–µ —В–Њ–≥–Њ, —Б –њ–Њ–Љ–Њ—Й—М—О –Љ–µ—Е–∞–љ–Є–Ј–Љ–∞ DCBX –≤–Ј–∞–Є–Љ–Њ–і–µ–є—Б—В–≤—Г—О—Й–Є–µ —Г—Б—В—А–Њ–є—Б—В–≤–∞ –Њ–њ—А–µ–і–µ–ї—П—О—В —Б–Њ–≤–Љ–µ—Б—В–Є–Љ–Њ—Б—В—М —Б–Њ—Б–µ–і–љ–µ–≥–Њ —Г—Б—В—А–Њ–є—Б—В–≤–∞ —Б DCE, —В.–µ. –Њ—З–µ—А—З–Є–≤–∞—О—В –ї–Њ–≥–Є—З–µ—Б–Ї—Г—О –≥—А–∞–љ–Є—Ж—Г –і–Њ–Љ–µ–љ–∞ DCE –≤ —Б–µ—В–Є –¶–Ю–Ф. –Ь–µ—Е–∞–љ–Є–Ј–Љ Data Center Bridging eXchange –Њ–њ–Є—Б–∞–љ –≤ —Б—В–∞–љ–і–∞—А—В–µ IEEE 802.1Qaz;

- Layer 2 Multi-Pathing (L2MP). –Т –Њ—В–ї–Є—З–Є–µ –Њ—В –Ї–ї–∞—Б—Б–Є—З–µ—Б–Ї–Њ–≥–Њ –њ—А–Њ—В–Њ–Ї–Њ–ї–∞ Spanning Tree, –±–ї–Њ–Ї–Є—А—Г—О—Й–µ–≥–Њ –Љ–љ–Њ–ґ–µ—Б—В–≤–µ–љ–љ—Л–µ —Б–Њ–µ–і–Є–љ–µ–љ–Є—П –Љ–µ–ґ–і—Г —Г–Ј–ї–∞–Љ–Є, –Љ–µ—Е–∞–љ–Є–Ј–Љ L2MP –Њ–±–µ—Б–њ–µ—З–Є–≤–∞–µ—В –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М –Њ–і–љ–Њ–≤—А–µ–Љ–µ–љ–љ–Њ–≥–Њ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—П –љ–µ—Б–Ї–Њ–ї—М–Ї–Є—Е –њ–∞—А–∞–ї–ї–µ–ї—М–љ—Л—Е –њ—Г—В–µ–є, –±–ї–∞–≥–Њ–і–∞—А—П —З–µ–Љ—Г –њ—А–Њ–њ—Г—Б–Ї–љ–∞—П —Б–њ–Њ—Б–Њ–±–љ–Њ—Б—В—М —А–∞—Б—Е–Њ–і—Г–µ—В—Б—П –±–Њ–ї–µ–µ —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ. –Ь–µ—Е–∞–љ–Є–Ј–Љ Layer 2 Multi-Pathing –Њ–њ–Є—Б–∞–љ –≤ —Б—В–∞–љ–і–∞—А—В–µ IEEE 802.1Qau.

–Ъ –Њ–њ—Ж–Є–Њ–љ–∞–ї—М–љ–Њ–Љ—Г —Д—Г–љ–Ї—Ж–Є–Њ–љ–∞–ї—Г –Њ—В–љ–Њ—Б–Є—В—Б—П —Б–ї–µ–і—Г—О—Й–µ–µ —А–∞—Б—И–Є—А–µ–љ–Є–µ:

- Congestion Notification –Њ–±–µ—Б–њ–µ—З–Є–≤–∞–µ—В —Б–Ї–≤–Њ–Ј–љ–Њ–µ —Г–њ—А–∞–≤–ї–µ–љ–Є–µ –њ–µ—А–µ–≥—А—Г–Ј–Ї–∞–Љ–Є —Б –њ–Њ–Љ–Њ—Й—М—О —В–µ—Е–љ–Њ–ї–Њ–≥–Є–є —Д–Њ—А–Љ–Є—А–Њ–≤–∞–љ–Є—П —В—А–∞—Д–Є–Ї–∞ –љ–∞ —Б—В–Њ—А–Њ–љ–µ –Њ—В–њ—А–∞–≤–Є—В–µ–ї—П –Є–љ—Д–Њ—А–Љ–∞—Ж–Є–Є: –њ—А–Є –њ–Њ–Љ–Њ—Й–Є –Љ–µ—Е–∞–љ–Є–Ј–Љ–∞ —Г–≤–µ–і–Њ–Љ–ї–µ–љ–Є–є —В–µ—Е–љ–Њ–ї–Њ–≥–Є—П —Г–њ—А–∞–≤–ї–µ–љ–Є—П –њ–µ—А–µ–≥—А—Г–Ј–Ї–∞–Љ–Є –њ–Њ—Б—Л–ї–∞–µ—В —Б–њ–µ—Ж–Є–∞–ї—М–љ—Л–µ —Б–Њ–Њ–±—Й–µ–љ–Є—П –Є—Б—В–Њ—З–љ–Є–Ї—Г —В—А–∞—Д–Є–Ї–∞ —Б –њ—А–Њ—Б—М–±–Њ–є –Ј–∞–Љ–µ–і–ї–Є—В—М –њ–µ—А–µ–і–∞—З—Г –≤ —Б–ї—Г—З–∞–µ –≤–Њ–Ј–љ–Є–Ї–љ–Њ–≤–µ–љ–Є—П –њ–µ—А–µ–≥—А—Г–Ј–Њ–Ї –љ–∞ –Ї–∞–Ї–Њ–Љ-–ї–Є–±–Њ —Г—З–∞—Б—В–Ї–µ —Б–µ—В–Є. –Ь–µ—Е–∞–љ–Є–Ј–Љ Congestion Notification –Њ–њ–Є—Б–∞–љ –≤ —Б—В–∞–љ–і–∞—А—В–µ IEEE 802.1Qau.

–Т—В–Њ—А–∞—П —Б–Њ—Б—В–∞–≤–ї—П—О—Й–µ–є –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л DCE вАФ "–Ї–Њ–Љ–Љ—Г—В–∞—Ж–Є–Њ–љ–љ–∞—П —Д–∞–±—А–Є–Ї–∞ –±–µ–Ј –њ–Њ—В–µ—А—М" (Lossless Ethernet Switch Fabric) вАФ —П–≤–ї—П–µ—В—Б—П –љ–µ –Љ–µ–љ–µ–µ –≤–∞–ґ–љ–Њ–є, —З–µ–Љ –љ–∞–±–Њ—А —А–∞—Б—И–Є—А–µ–љ–Є–є Ethernet. –Ф–ї—П —В–Њ–≥–Њ —З—В–Њ–±—Л –Њ–±–µ—Б–њ–µ—З–Є—В—М —А–µ–∞–ї—М–љ—Г—О –њ–µ—А–µ–і–∞—З—Г –њ–Њ Ethernet –±–µ–Ј –њ–Њ—В–µ—А—М (Lossless Ethernet), –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ —А–µ–∞–ї–Є–Ј–Њ–≤–∞—В—М –і–≤–∞ –Њ–±—П–Ј–∞—В–µ–ї—М–љ—Л—Е —В—А–µ–±–Њ–≤–∞–љ–Є—П: –Љ–µ—Е–∞–љ–Є–Ј–Љ –њ—А–Є–Њ—Б—В–∞–љ–Њ–≤–Ї–Є –њ–µ—А–µ–і–∞—З–Є —В—А–∞—Д–Є–Ї–∞ –њ–Њ –Ї–∞–љ–∞–ї—Г –≤ —Б–Њ–Њ—В–≤–µ—В—Б—В–≤–Є–Є —Б –Ї–ї–∞—Б—Б–Њ–Љ —В—А–∞—Д–Є–Ї–∞, —В–∞–Ї–Њ–є –Ї–∞–Ї PFC, –Є –Љ–µ—В–Њ–і –њ—А–Є–Њ—Б—В–∞–љ–Њ–≤–Ї–Є —В—А–∞—Д–Є–Ї–∞ –Њ—В –≤—Е–Њ–і—П—Й–µ–≥–Њ –Ї –Є—Б—Е–Њ–і—П—Й–µ–Љ—Г –њ–Њ—А—В—Г —З–µ—А–µ–Ј –≤–љ—Г—В—А–µ–љ–љ—О—О –Ї–Њ–Љ–Љ—Г—В–∞—Ж–Є–Њ–љ–љ—Г—О —Д–∞–±—А–Є–Ї—Г.

–Я–µ—А–µ–і–∞—З–∞ —В—А–∞—Д–Є–Ї–∞ –±–µ–Ј –њ–Њ—В–µ—А—М –≤–љ—Г—В—А–Є –Ї–Њ–Љ–Љ—Г—В–∞—Ж–Є–Њ–љ–љ–Њ–є —Д–∞–±—А–Є–Ї–Є –і–Њ—Б—В–Є–≥–∞–µ—В—Б—П –Ј–∞ —Б—З–µ—В –Њ–±—К–µ–і–Є–љ–µ–љ–Є—П –Љ–µ—Е–∞–љ–Є–Ј–Љ–∞ PFC –і–ї—П –њ—А–Є–Њ—Б—В–∞–љ–Њ–≤–Ї–Є —В—А–∞—Д–Є–Ї–∞ –љ–∞ –≤—Е–Њ–і–љ–Њ–Љ –њ–Њ—А—В—Г –Ї–Њ–Љ–Љ—Г—В–∞—В–Њ—А–∞ –Є –Љ–µ—Е–∞–љ–Є–Ј–Љ–∞ —Г–њ—А–∞–≤–ї–µ–љ–Є—П –Њ—З–µ—А–µ–і—П–Љ–Є –љ–∞ –≤—Л—Е–Њ–і–љ–Њ–Љ –њ–Њ—А—В—Г –Ї–Њ–Љ–Љ—Г—В–∞—В–Њ—А–∞ –і–ї—П –њ—А–µ–і–Њ—В–≤—А–∞—Й–µ–љ–Є—П –њ–µ—А–µ–і–∞—З–Є –њ–∞–Ї–µ—В–Њ–≤ –≤–љ—Г—В—А–Є —Д–∞–±—А–Є–Ї–Є –≤ —Б–ї—Г—З–∞–µ –љ–µ–і–Њ—Б—В—Г–њ–љ–Њ—Б—В–Є –≤—Л—Е–Њ–і–љ–Њ–≥–Њ –њ–Њ—А—В–∞ (–Љ–µ—Е–∞–љ–Є–Ј–Љ Virtual Output Queues, VOQ). –Ґ–∞–Ї–Є–Љ –Њ–±—А–∞–Ј–Њ–Љ, –њ—А–Є —Б–Њ–±–ї—О–і–µ–љ–Є–Є –і–≤—Г—Е —Г–њ–Њ–Љ—П–љ—Г—В—Л—Е –≤—Л—И–µ —В—А–µ–±–Њ–≤–∞–љ–Є–є —А–µ–∞–ї–Є–Ј—Г–µ—В—Б—П –њ–Њ–ї–љ–Њ—Ж–µ–љ–љ—Л–є —Б–Ї–≤–Њ–Ј–љ–Њ–є Ethernet –±–µ–Ј –њ–Њ—В–µ—А—М. –Э–∞ –†–Є—Б—Г–љ–Ї–µ 5 –њ—А–µ–і—Б—В–∞–≤–ї–µ–љ —Д—А–∞–≥–Љ–µ–љ—В –Ї–Њ–љ–≤–µ—А–≥–µ–љ—В–љ–Њ–є —Б–µ—В–Є, –≤–Ї–ї—О—З–∞—О—Й–Є–є –≤ —Б–µ–±—П —Б–µ—А–≤–µ—А–љ–Њ–µ –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є–µ –Є –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є–µ —Б–µ—В–Є —Е—А–∞–љ–µ–љ–Є—П, –≥–і–µ –і–ї—П –≤–Ј–∞–Є–Љ–Њ–і–µ–є—Б—В–≤–Є—П –≤—Б–µ—Е —Г—Б—В—А–Њ–є—Б—В–≤ –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В—Б—П –њ—А–Њ—В–Њ–Ї–Њ–ї FCoE. –Ч–∞ –Њ—В—Б—Г—В—Б—В–≤–Є–µ –њ–Њ—В–µ—А—М –љ–∞ —Б–Њ–µ–і–Є–љ–Є—В–µ–ї—М–љ—Л—Е –Ї–∞–љ–∞–ї–∞—Е –Њ—В–≤–µ—З–∞–µ—В –Љ–µ—Е–∞–љ–Є–Ј–Љ PFC, –∞ —В–µ—Е–љ–Њ–ї–Њ–≥–Є—П —Г–њ—А–∞–≤–ї–µ–љ–Є—П –Њ—З–µ—А–µ–і—П–Љ–Є –≤–љ—Г—В—А–Є –Ї–Њ–Љ–Љ—Г—В–∞—В–Њ—А–Њ–≤ (VOQ) –њ–Њ–Ј–≤–Њ–ї—П–µ—В –Њ–±–µ—Б–њ–µ—З–Є—В—М –≥–∞—А–∞–љ—В–Є—А–Њ–≤–∞–љ–љ—Г—О –њ–µ—А–µ–і–∞—З—Г –њ–∞–Ї–µ—В–Њ–≤ –≤–љ—Г—В—А–Є –Ї–Њ–Љ–Љ—Г—В–∞—Ж–Є–Њ–љ–љ–Њ–є —Д–∞–±—А–Є–Ї–Є.

–°—В—А–Њ–Є—В–µ–ї—М–љ—Л–µ –±–ї–Њ–Ї–Є

–Ъ–∞–Ї–Є–µ –ґ–µ –Є–Љ–µ–љ–љ–Њ –Ї–Њ–Љ–њ–Њ–љ–µ–љ—В—Л –њ–Њ—В—А–µ–±—Г—О—В—Б—П –і–ї—П –њ–Њ—Б—В—А–Њ–µ–љ–Є—П —В—А–∞–љ—Б–њ–Њ—А—В–љ–Њ–є –њ–ї–∞—В—Д–Њ—А–Љ—Л –¶–Ю–Ф —Б –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ–Љ —В–µ—Е–љ–Њ–ї–Њ–≥–Є–є —Г–љ–Є—Д–Є—Ж–Є—А–Њ–≤–∞–љ–љ—Л—Е —Д–∞–±—А–Є–Ї?

–Т–Њ-–њ–µ—А–≤—Л—Е, –љ–µ–Њ–±—Е–Њ–і–Є–Љ—Л –Ї–Њ–љ–≤–µ—А–≥–µ–љ—В–љ—Л–µ –Ї–Њ–Љ–Љ—Г—В–∞—В–Њ—А—Л —Б –њ–Њ–і–і–µ—А–ґ–Ї–Њ–є —В–µ—Е–љ–Њ–ї–Њ–≥–Є–є 10 Gigabit Ethernet, FCoE –Є DCE. –†–∞–љ—М—И–µ –і—А—Г–≥–Є—Е –≥–Њ—В–Њ–≤–Њ–µ —А–µ—И–µ–љ–Є–µ –і–ї—П –њ–Њ—Б—В—А–Њ–µ–љ–Є—П –Ї–Њ–љ—Б–Њ–ї–Є–і–Є—А–Њ–≤–∞–љ–љ–Њ–є —В—А–∞–љ—Б–њ–Њ—А—В–љ–Њ–є –њ–ї–∞—В—Д–Њ—А–Љ—Л –њ—А–µ–і—Б—В–∞–≤–Є–ї–∞ –Ї–Њ–Љ–њ–∞–љ–Є—П Cisco. –Ъ–Њ–Љ–Љ—Г—В–∞—В–Њ—А—Л —Б–µ–Љ–µ–є—Б—В–≤–∞ Nexus 5000 –Њ—Б–љ–∞—Й–µ–љ—Л –Є–љ—В–µ—А—Д–µ–є—Б–∞–Љ–Є 10GbE, –њ–Њ–і–і–µ—А–ґ–Є–≤–∞—О—В —В–µ—Е–љ–Њ–ї–Њ–≥–Є—О FCoE –Є DCE, –∞ —В–∞–Ї–ґ–µ —Б–Њ–і–µ—А–ґ–∞—В –Њ–і–Є–љ –Є–ї–Є –і–≤–∞ —Б–ї–Њ—В–∞ –і–ї—П –Љ–Њ–і—Г–ї–µ–є —А–∞—Б—И–Є—А–µ–љ–Є—П. –Я–Њ—Б–ї–µ–і–љ–Є–µ –њ–Њ–Ј–≤–Њ–ї—П—О—В —Г–≤–µ–ї–Є—З–Є—В—М –њ–Њ—А—В–Њ–≤—Г—О –µ–Љ–Ї–Њ—Б—В—М 10GE/DCE/FCoE –ї–Є–±–Њ –Њ–±–µ—Б–њ–µ—З–Є—В—М –њ–Њ–і–і–µ—А–ґ–Ї—Г –њ–Њ—А—В–Њ–≤ —Б –Є–љ—В–µ—А—Д–µ–є—Б–Њ–Љ –Ї–ї–∞—Б—Б–Є—З–µ—Б–Ї–Њ–≥–Њ FC. –Ґ–∞–Ї–Є–Љ –Њ–±—А–∞–Ј–Њ–Љ, –і–∞–љ–љ—Л–µ –Ї–Њ–Љ–Љ—Г—В–∞—В–Њ—А—Л –Љ–Њ–≥—Г—В –њ—А–Є–Љ–µ–љ—П—В—М—Б—П –і–ї—П –Ї–Њ–љ—Б–Њ–ї–Є–і–∞—Ж–Є–Є –≤–≤–Њ–і–∞/–≤—Л–≤–Њ–і–∞ –љ–∞ —Г—А–Њ–≤–љ–µ –і–Њ—Б—В—Г–њ–∞ –¶–Ю–Ф. –Ю–љ–Є –Њ–±–µ—Б–њ–µ—З–Є–≤–∞—О—В —Д—Г–љ–Ї—Ж–Є–Њ–љ–∞–ї —И–ї—О–Ј–∞ –Љ–µ–ґ–і—Г –Ї–Њ–љ–≤–µ—А–≥–µ–љ—В–љ–Њ–є –Є —В—А–∞–і–Є—Ж–Є–Њ–љ–љ–Њ–є —З–∞—Б—В—П–Љ–Є –¶–Ю–Ф –Є —В–µ–Љ —Б–∞–Љ—Л–Љ –њ–Њ–Ј–≤–Њ–ї—П—О—В –Њ—Б—Г—Й–µ—Б—В–≤–ї—П—В—М –њ–ї–∞–≤–љ—Г—О –Љ–Є–≥—А–∞—Ж–Є—О –Њ—В —Г–љ–∞—Б–ї–µ–і–Њ–≤–∞–љ–љ–Њ–є –Є–љ—Д—А–∞—Б—В—А—Г–Ї—В—Г—А—Л –Ї —Г–љ–Є—Д–Є—Ж–Є—А–Њ–≤–∞–љ–љ–Њ–є —В—А–∞–љ—Б–њ–Њ—А—В–љ–Њ–є –њ–ї–∞—В—Д–Њ—А–Љ–µ. –Ю–±–Њ–±—Й–µ–љ–љ–∞—П —Б—Е–µ–Љ–∞ —Б–µ—В–Є –¶–Ю–Ф, –≤–Ї–ї—О—З–∞—О—Й–∞—П –≤ —Б–µ–±—П –Ї–∞–Ї —В—А–∞–і–Є—Ж–Є–Њ–љ–љ—Г—О, —В–∞–Ї –Є –Ї–Њ–љ–≤–µ—А–≥–µ–љ—В–љ—Г—О —З–∞—Б—В—М, –њ—А–µ–і—Б—В–∞–≤–ї–µ–љ–∞ –љ–∞ –†–Є—Б—Г–љ–Ї–µ 6.

–Т–Њ-–≤—В–Њ—А—Л—Е, –і–ї—П —В–Њ–≥–Њ —З—В–Њ–±—Л –њ–Њ–і–Ї–ї—О—З–Є—В—М —Б–µ—А–≤–µ—А—Л –Ї –Ї–Њ–љ–≤–µ—А–≥–µ–љ—В–љ–Њ–є —Б–µ—В–Є, –љ—Г–ґ–љ—Л —Б–њ–µ—Ж–Є–∞–ї–Є–Ј–Є—А–Њ–≤–∞–љ–љ—Л–µ –∞–і–∞–њ—В–µ—А—Л. –Ю–љ–Є –Ј–∞–Љ–µ–љ—П—О—В —Б–Њ–±–Њ–є —В—А–∞–і–Є—Ж–Є–Њ–љ–љ—Л–є –љ–∞–±–Њ—А –∞–і–∞–њ—В–µ—А–Њ–≤ –ї–Њ–Ї–∞–ї—М–љ–Њ–є —Б–µ—В–Є (Network Interface Card, NIC), –∞–і–∞–њ—В–µ—А–Њ–≤ —Б–µ—В–Є —Е—А–∞–љ–µ–љ–Є—П (Host Bus Adapter, HBA) –Є –∞–і–∞–њ—В–µ—А–Њ–≤ –і–ї—П –њ–Њ–і–Ї–ї—О—З–µ–љ–Є—П –Ї —Б–µ—В—П–Љ –Љ–µ–ґ–Ї–ї–∞—Б—В–µ—А–љ–Њ–≥–Њ –≤–Ј–∞–Є–Љ–Њ–і–µ–є—Б—В–≤–Є—П (Host Channel Adapter, HCA), –Њ–±–µ—Б–њ–µ—З–Є–≤–∞—П –њ–µ—А–µ–і–∞—З—Г –≤—Б–µ—Е –≤–Є–і–Њ–≤ —В—А–∞—Д–Є–Ї–∞ —З–µ—А–µ–Ј –µ–і–Є–љ—Л–є —Г–љ–Є—Д–Є—Ж–Є—А–Њ–≤–∞–љ–љ—Л–є –∞–і–∞–њ—В–µ—А –≤–≤–Њ–і–∞/–≤—Л–≤–Њ–і–∞.

–Р–і–∞–њ—В–µ—А—Л –Љ–Њ–≥—Г –±—Л—В—М –і–≤—Г—Е –≤–Є–і–Њ–≤: —Б–њ–µ—Ж–Є–∞–ї–Є–Ј–Є—А–Њ–≤–∞–љ–љ—Л–є –Ї–Њ–љ–≤–µ—А–≥–µ–љ—В–љ—Л–є –∞–і–∞–њ—В–µ—А (Convergent Network Adapter, CNA) –Є –Њ–±—Л—З–љ—Л–µ —Б–µ—В–µ–≤—Л–µ –Ї–∞—А—В—Л Ethernet 10GE —Б –њ—А–Њ–≥—А–∞–Љ–Љ–љ–Њ–є —А–µ–∞–ї–Є–Ј–∞—Ж–Є–µ–є —Б—В–µ–Ї–∞ FCoE. –Р–і–∞–њ—В–µ—А –њ–µ—А–≤–Њ–≥–Њ —В–Є–њ–∞ –њ—А–µ–і—Б—В–∞–≤–ї—П–µ—В —Б–Њ–±–Њ–є —Г—Б—В—А–Њ–є—Б—В–≤–Њ, –Њ–±—К–µ–і–Є–љ—П—О—Й–µ–µ –≤ —Б–µ–±–µ —Д—Г–љ–Ї—Ж–Є–Є —Б—В–∞–љ–і–∞—А—В–љ–Њ–≥–Њ –∞–і–∞–њ—В–µ—А–∞ –ї–Њ–Ї–∞–ї—М–љ–Њ–є —Б–µ—В–Є (NIC) –Є SAN (HBA). –Ю–љ —Б–Њ–і–µ—А–ґ–Є—В –љ–∞–±–Њ—А –ї–Њ–≥–Є–Ї–Є –Њ–±–µ–Є—Е –Ї–∞—А—В (NIC –Є HBA) –Є —Б–њ–µ—Ж–Є–∞–ї–Є–Ј–Є—А–Њ–≤–∞–љ–љ—Л–є —Г–њ—А–∞–≤–ї—П—О—Й–Є–є –Љ—Г–ї—М—В–Є–њ–ї–µ–Ї—Б–Њ—А вАФ —Д–∞–Ї—В–Є—З–µ—Б–Ї–Є —Н—В–Њ –і–≤–∞ –∞–і–∞–њ—В–µ—А–∞ –≤ –Њ–і–љ–Њ–Љ. –Ґ–∞–Ї–Њ–µ —А–µ—И–µ–љ–Є–µ –њ–Њ–Ј–≤–Њ–ї—П–µ—В –њ—А–Є–Љ–µ–љ—П—В—М –љ–∞–±–Њ—А —Б—В–∞–љ–і–∞—А—В–љ—Л—Е –і—А–∞–є–≤–µ—А–Њ–≤ –Є —Г—В–Є–ї–Є—В –і–ї—П —Г—Б—В–∞–љ–Њ–≤–Ї–Є –Є –∞–і–Љ–Є–љ–Є—Б—В—А–Є—А–Њ–≤–∞–љ–Є—П.

–Ч–∞–Љ–µ—В–Є–Љ, —З—В–Њ, –љ–∞–њ—А–Є–Љ–µ—А, –Њ–њ–µ—А–∞—Ж–Є–Њ–љ–љ–∞—П —Б–Є—Б—В–µ–Љ–∞ Windows –њ–Њ—Б–ї–µ —Г—Б—В–∞–љ–Њ–≤–Ї–Є –Ї–Њ–љ–≤–µ—А–≥–µ–љ—В–љ–Њ–≥–Њ –∞–і–∞–њ—В–µ—А–∞ —Б–Њ–Њ–±—Й–∞–µ—В –Њ –љ–∞–ї–Є—З–Є–Є –≤ —Б–Є—Б—В–µ–Љ–µ –і–≤—Г—Е —А–∞–Ј–і–µ–ї—М–љ—Л—Е –ї–Њ–≥–Є—З–µ—Б–Ї–Є—Е –Ї–∞—А—В вАУ –ї–Њ–Ї–∞–ї—М–љ–Њ–є —Б–µ—В–Є –Є SAN, —Е–Њ—В—П –≤ –і–µ–є—Б—В–≤–Є—В–µ–ї—М–љ–Њ—Б—В–Є –≤ —Б–Є—Б—В–µ–Љ–µ —Г—Б—В–∞–љ–Њ–≤–ї–µ–љ –µ–і–Є–љ—Л–є –Ї–Њ–љ–≤–µ—А–≥–µ–љ—В–љ—Л–є –∞–і–∞–њ—В–µ—А. –Я–Њ–і–Њ–±–љ—Л–µ —Г—Б—В—А–Њ–є—Б—В–≤–∞ –≤—Л–њ—Г—Б–Ї–∞—О—В –Ї–Њ–Љ–њ–∞–љ–Є–Є Emulex –Є QLogic. –Ф–Њ—Б—В—Г–њ–љ—Л–µ –љ–∞ —А—Л–љ–Ї–µ –Ї–∞—А—В—Л –Њ—В–љ–Њ—Б—П—В—Б—П –Ї –њ–µ—А–≤–Њ–Љ—Г –њ–Њ–Ї–Њ–ї–µ–љ–Є—О –Є –Є–Љ–µ—О—В —А—П–і –љ–µ–і–Њ—Б—В–∞—В–Ї–Њ–≤, –≤ —З–Є—Б–ї–µ –Ї–Њ—В–Њ—А—Л—Е вАФ –±–Њ–ї—М—И–Є–µ —А–∞–Ј–Љ–µ—А—Л, –Є–Ј–±—Л—В–Њ—З–љ—Л–µ —Н–љ–µ—А–≥–Њ–њ–Њ—В—А–µ–±–ї–µ–љ–Є–µ –Є —В–µ–њ–ї–Њ–≤—Л–і–µ–ї–µ–љ–Є–µ, –Њ—В–љ–Њ—Б–Є—В–µ–ї—М–љ–Њ –≤—Л—Б–Њ–Ї–∞—П —Ж–µ–љ–∞. –Т–њ—А–Њ—З–µ–Љ, –≤ –±–ї–Є–ґ–∞–є—И–µ–µ –≤—А–µ–Љ—П –і–Њ–ї–ґ–љ—Л –њ–Њ—П–≤–Є—В—М—Б—П –∞–і–∞–њ—В–µ—А—Л –≤—В–Њ—А–Њ–≥–Њ –њ–Њ–Ї–Њ–ї–µ–љ–Є—П —Б —Г–љ–Є—Д–Є—Ж–Є—А–Њ–≤–∞–љ–љ—Л–Љ –љ–∞–±–Њ—А–Њ–Љ –ї–Њ–≥–Є–Ї–Є, –Ї–Њ—В–Њ—А—Л–µ –±—Г–і—Г—В –Љ–µ–љ—М—И–µ –њ–Њ —А–∞–Ј–Љ–µ—А–∞–Љ, –њ—А–Є—З–µ–Љ –Њ–ґ–Є–і–∞–µ—В—Б—П, —З—В–Њ —Н–љ–µ—А–≥–Њ–њ–Њ—В—А–µ–±–ї–µ–љ–Є–µ –Є —В–µ–њ–ї–Њ–≤—Л–і–µ–ї–µ–љ–Є–µ —Г–Љ–µ–љ—М—И–∞—В—Б—П, –∞ —Ж–µ–љ–∞ —Б–љ–Є–Ј–Є—В—Б—П.

–Р–і–∞–њ—В–µ—А—Л –≤—В–Њ—А–Њ–≥–Њ —В–Є–њ–∞ —Б –њ—А–Њ–≥—А–∞–Љ-–Љ–љ–Њ–є —А–µ–∞–ї–Є–Ј–∞—Ж–Є–µ–є —Б—В–µ–Ї–∞ F–°oE –Њ—В–ї–Є—З–∞—О—В—Б—П –Ј–љ–∞—З–Є—В–µ–ї—М–љ–Њ –±–Њ–ї–µ–µ –љ–Є–Ј–Ї–Њ–є —Ж–µ–љ–Њ–є –њ–Њ —Б—А–∞–≤–љ–µ–љ–Є—О —Б–Њ —Б–њ–µ—Ж–Є–∞–ї–Є–Ј–Є—А–Њ–≤–∞–љ–љ—Л–Љ–Є –Ї–Њ–љ–≤–µ—А–≥–µ–љ—В–љ—Л–Љ–Є –∞–і–∞–њ—В–µ—А–∞–Љ–Є, –љ–Њ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М –Є—Е –љ–Є–ґ–µ. –Ъ—А–Њ–Љ–µ —В–Њ–≥–Њ, –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ —Г—З–µ—Б—В—М –≤–Њ–Ј–Љ–Њ–ґ–љ—Л–µ –њ—А–Њ–±–ї–µ–Љ—Л —Б —Б–Њ–≤–Љ–µ—Б—В–Є–Љ–Њ—Б—В—М—О –Є —Б–µ—А—В–Є—Д–Є–Ї–∞—Ж–Є–µ–є –њ–Њ–і–Њ–±–љ–Њ–≥–Њ —А–µ—И–µ–љ–Є—П.

–Ю—В–љ–Њ—Б–Є—В–µ–ї—М–љ–Њ —В—А–µ–±–Њ–≤–∞–љ–Є–є, –њ—А–µ–і—К—П–≤–ї—П–µ–Љ—Л—Е –Ї —А–∞—Б—Б–Љ–Њ—В—А–µ–љ–љ—Л–Љ –≤—Л—И–µ –Ї–Њ–Љ–њ–Њ–љ–µ–љ—В–∞–Љ —Б —В–Њ—З–Ї–Є –Ј—А–µ–љ–Є—П –њ–Њ–і–і–µ—А–ґ–Ї–Є —В–µ—Е–љ–Њ–ї–Њ–≥–Є–Є DCE, –Љ–Њ–ґ–љ–Њ —Б–Ї–∞–Ј–∞—В—М —Б–ї–µ–і—Г—О—Й–µ–µ: –Ї–Њ–Љ–Љ—Г—В–∞—В–Њ—А –і–Њ–ї–ґ–µ–љ –њ–Њ–і–і–µ—А–ґ–Є–≤–∞—В—М Lossless Ethernet Switch Fabric, L2MP, PFC, ETS, DCBX, –∞ –Ї–Њ–љ–µ—З–љ–Њ–µ —Г—Б—В—А–Њ–є—Б—В–≤–Њ (—Б–µ—А–≤–µ—А, —Б–Є—Б—В–µ–Љ–∞ —Е—А–∞–љ–µ–љ–Є—П –Є —В.–њ.) вАФ PFC, ETS, DCBX. –Я–Њ–і–і–µ—А–ґ–Ї–∞ –Љ–µ—Е–∞–љ–Є–Ј–Љ–∞ Congestion Notification —П–≤–ї—П–µ—В—Б—П –Њ–њ—Ж–Є–Њ–љ–∞–ї—М–љ–Њ–є.

–Т–љ–µ–і—А—П—В—М –Є–ї–Є –љ–µ –≤–љ–µ–і—А—П—В—М

–Т–љ–µ–і—А–µ–љ–Є–µ —В–µ—Е–љ–Њ–ї–Њ–≥–Є–Є —Г–љ–Є—Д–Є—Ж–Є—А–Њ–≤–∞–љ–љ—Л—Е —Д–∞–±—А–Є–Ї –≤ —Г–ґ–µ —Б—Г—Й–µ—Б—В–≤—Г—О—Й–µ–Љ –¶–Ю–Ф –љ–µ —В—А–µ–±—Г–µ—В –љ–µ–Љ–µ–і–ї–µ–љ–љ–Њ–є –Ј–∞–Љ–µ–љ—Л –≤—Б–µ–≥–Њ —Г–љ–∞—Б–ї–µ–і–Њ–≤–∞–љ–љ–Њ–≥–Њ –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є—П. –С–ї–∞–≥–Њ–і–∞—А—П —Б–Њ—Е—А–∞–љ–µ–љ–Є—О –Є–і–µ–Њ–ї–Њ–≥–Є–Є –Є –Є–љ—Б—В—А—Г–Љ–µ–љ—В–Њ–≤ —Г–њ—А–∞–≤–ї–µ–љ–Є—П —В—А–∞–і–Є—Ж–Є–Њ–љ–љ–Њ–є —Б–µ—В–Є SAN, –њ–Њ–і–і–µ—А–ґ–Ї–µ —Д—Г–љ–Ї—Ж–Є–Њ–љ–∞–ї–∞ —И–ї—О–Ј–∞ –Љ–µ–ґ–і—Г —В—А–∞–і–Є—Ж–Є–Њ–љ–љ–Њ–є –Є –Ї–Њ–љ–≤–µ—А–≥–µ–љ—В–љ–Њ–є —З–∞—Б—В—П–Љ–Є –¶–Ю–Ф, –∞ —В–∞–Ї–ґ–µ —Б–Њ—Е—А–∞–љ–µ–љ–Є—О —А–∞–Ј–і–µ–ї–µ–љ–Є—П –∞–і–Љ–Є–љ–Є—Б—В—А–∞—В–Є–≤–љ—Л—Е –њ–Њ–ї–љ–Њ–Љ–Њ—З–Є–є –њ—А–Є —Г–њ—А–∞–≤–ї–µ–љ–Є–Є –ї–Њ–Ї–∞–ї—М–љ–Њ–є —Б–µ—В—М—О –Є —Б–µ—В—М—О —Е—А–∞–љ–µ–љ–Є—П –Ї–∞–Ї —З–∞—Б—В—П–Љ–Є —В—А–∞–љ—Б–њ–Њ—А—В–љ–Њ–є –Є–љ—Д—А–∞—Б—В—А—Г–Ї—В—Г—А—Л, –Љ–Є–≥—А–∞—Ж–Є—О –Љ–Њ–ґ–љ–Њ –Њ—Б—Г—Й–µ—Б—В–≤–ї—П—В—М –њ–Њ—Б—В–µ–њ–µ–љ–љ–Њ, –Є—Б–њ–Њ–ї—М–Ј—Г—П –Њ–і–љ–Њ–≤—А–µ–Љ–µ–љ–љ–Њ –Є –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є–µ —Б –Ї–Њ–љ–≤–µ—А–≥–µ–љ—В–љ—Л–Љ–Є –Є–љ—В–µ—А—Д–µ–є—Б–∞–Љ–Є, –Є —Г–љ–∞—Б–ї–µ–і–Њ–≤–∞–љ–љ–Њ–µ –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є–µ.

–Я–Њ —Б—А–∞–≤–љ–µ–љ–Є—О —Б —В—А–∞–і–Є—Ж–Є–Њ–љ–љ–Њ–є –Є–љ—Д—А–∞—Б—В—А—Г–Ї—В—Г—А–Њ–є, –≥–і–µ –і–ї—П —А–∞–Ј–ї–Є—З–љ—Л—Е —В–Є–њ–Њ–≤ —В—А–∞—Д–Є–Ї–∞ –≤—Л–і–µ–ї—П—О—В—Б—П –Њ—В–і–µ–ї—М–љ—Л–µ —Б–µ—В–Є, –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ —В–µ—Е–љ–Њ–ї–Њ–≥–Є–Є —Г–љ–Є—Д–Є—Ж–Є—А–Њ–≤–∞–љ–љ—Л—Е —Д–∞–±—А–Є–Ї –њ–Њ–Ј–≤–Њ–ї—П–µ—В —Б–љ–Є–Ј–Є—В—М —Б–Њ–≤–Њ–Ї—Г–њ–љ—Г—О —Б—В–Њ–Є–Љ–Њ—Б—В—М –≤–ї–∞–і–µ–љ–Є—П —В—А–∞–љ—Б–њ–Њ—А—В–љ–Њ–є –Є–љ—Д—А–∞—Б—В—А—Г–Ї—В—Г—А–Њ–є –¶–Ю–Ф –Ј–∞ —Б—З–µ—В —Б–ї–µ–і—Г—О—Й–Є—Е –Њ—Б–Њ–±–µ–љ–љ–Њ—Б—В–µ–є:

- —Г–Љ–µ–љ—М—И–µ–љ–Є–µ –Ї–Њ–ї–Є—З–µ—Б—В–≤–∞ —Б–µ—В–µ–≤—Л—Е –∞–і–∞–њ—В–µ—А–Њ–≤ –і–ї—П –њ–Њ–і–Ї–ї—О—З–µ–љ–Є—П –Ї —Б–µ—В—П–Љ —А–∞–Ј–ї–Є—З–љ–Њ–≥–Њ —В–Є–њ–∞ вАУ –≤–Љ–µ—Б—В–Њ –љ–µ—Б–Ї–Њ–ї—М–Ї–Є—Е –∞–і–∞–њ—В–µ—А–Њ–≤ –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В—Б—П –Њ–і–Є–љ –Ї–Њ–љ–≤–µ—А–≥–µ–љ—В–љ—Л–є –∞–і–∞–њ—В–µ—А, –Ї–Њ—В–Њ—А—Л–є –Њ–±–µ—Б–њ–µ—З–Є–≤–∞–µ—В –њ–µ—А–µ–і–∞—З—Г –≤—Б–µ—Е —В–Є–њ–Њ–≤ —В—А–∞—Д–Є–Ї–∞;

- —Б–Њ–Ї—А–∞—Й–µ–љ–Є–µ –Ї–Њ–ї–Є—З–µ—Б—В–≤–∞ –љ–µ–Њ–±—Е–Њ–і–Є–Љ—Л—Е –Ї–∞–±–µ–ї—М–љ—Л—Е —Б–Њ–µ–і–Є–љ–µ–љ–Є–є, –Ї–Њ–Љ–Љ—Г—В–∞—Ж–Є–Њ–љ–љ—Л—Е –њ–∞–љ–µ–ї–µ–є, –Њ—А–≥–∞–љ–∞–є–Ј–µ—А–Њ–≤, –ї–Њ—В–Ї–Њ–≤ –Є –і—А—Г–≥–Є—Е —Н–ї–µ–Љ–µ–љ—В–Њ–≤ –°–Ъ–°;

- —Б–љ–Є–ґ–µ–љ–Є–µ –Ї–Њ–ї–Є—З–µ—Б—В–≤–∞ –њ–Њ–і–Ї–ї—О—З–µ–љ–љ—Л—Е –њ–Њ—А—В–Њ–≤ –љ–∞ –Ї–Њ–Љ–Љ—Г—В–Є—А—Г—О—Й–µ–Љ –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є–Є;

- —Г–Љ–µ–љ—М—И–µ–љ–Є–µ —Б—Г–Љ–Љ–∞—А–љ–Њ–≥–Њ —Н–љ–µ—А–≥–Њ–њ–Њ—В—А–µ–±–ї–µ–љ–Є—П –Є —В–µ–њ–ї–Њ–≤—Л–і–µ–ї–µ–љ–Є—П –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є—П;

- –њ–Њ–≤—Л—И–µ–љ–Є–µ –Ї–Њ—Н—Д—Д–Є—Ж–Є–µ–љ—В–∞ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—П –≤—Л—Б–Њ–Ї–Њ—Б–Ї–Њ—А–Њ—Б—В–љ—Л—Е —Б–Њ–µ–і–Є–љ–µ–љ–Є–є –Є —Н–ї–µ–Љ–µ–љ—В–Њ–≤ —В—А–∞–љ—Б–њ–Њ—А—В–љ–Њ–є –Є–љ—Д—А–∞—Б—В—А—Г–Ї—В—Г—А—Л;

- —Б–љ–Є–ґ–µ–љ–Є–µ —Б–Њ–≤–Њ–Ї—Г–њ–љ–Њ–є —Б—В–Њ–Є–Љ–Њ—Б—В–Є –≤–ї–∞–і–µ–љ–Є—П —В—А–∞–љ—Б–њ–Њ—А—В–љ–Њ–є –Є–љ—Д—А–∞—Б—В—А—Г–Ї—В—Г—А–Њ–є.

–Ф–ї—П –Є–ї–ї—О—Б—В—А–∞—Ж–Є–Є –≤–Њ–Ј–Љ–Њ–ґ–љ—Л—Е —Н–Ї–Њ–љ–Њ–Љ–Є—З–µ—Б–Ї–Є—Е –≤—Л–≥–Њ–і –њ—А–Є –≤–љ–µ–і—А–µ–љ–Є–Є –Є –і–∞–ї—М–љ–µ–є—И–µ–є —Н–Ї—Б–њ–ї—Г–∞—В–∞—Ж–Є–Є —В—А–∞–љ—Б–њ–Њ—А—В–љ–Њ–є –њ–ї–∞—В—Д–Њ—А–Љ—Л, –њ–Њ—Б—В—А–Њ–µ–љ–љ–Њ–є —Б –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ–Љ —В–µ—Е–љ–Њ–ї–Њ–≥–Є–є —Г–љ–Є—Д–Є—Ж–Є—А–Њ–≤–∞–љ–љ—Л—Е —Д–∞–±—А–Є–Ї, —А–∞—Б—Б–Љ–Њ—В—А–Є–Љ –≥–Є–њ–Њ—В–µ—В–Є—З–µ—Б–Ї–Є–є –¶–Ю–Ф, –≥–і–µ —Г—Б—В–∞–љ–Њ–≤–ї–µ–љ–Њ –Њ–Ї–Њ–ї–Њ 200 —Б–µ—А–≤–µ—А–Њ–≤. –°–Њ–≤–Њ–Ї—Г–њ–љ—Г—О —Б—В–Њ–Є–Љ–Њ—Б—В—М –≤–ї–∞–і–µ–љ–Є—П –і–ї—П —В—А–∞–і–Є—Ж–Є–Њ–љ–љ–Њ–є –Є –Ї–Њ–љ—Б–Њ–ї–Є–і–Є—А–Њ–≤–∞–љ–љ–Њ–є –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л —Б—А–∞–≤–љ–Є–Љ –Є—Б—Е–Њ–і—П –Є–Ј –њ—П—В–Є–ї–µ—В–љ–µ–≥–Њ —Б—А–Њ–Ї–∞ —Н–Ї—Б–њ–ї—Г–∞—В–∞—Ж–Є–Є. –Ф–ї—П —А–∞—Б—З–µ—В–∞ –≤–Њ—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Б—П —Д–Є—А–Љ–µ–љ–љ–Њ–є –Љ–µ—В–Њ–і–Є–Ї–Њ–є –Њ—Ж–µ–љ–Ї–Є TCO –Ї–Њ–Љ–њ–∞–љ–Є–Є Cisco. –Т–Њ –≤–љ–Є–Љ–∞–љ–Є–µ –њ—А–Є–љ–Є–Љ–∞—О—В—Б—П —Б–ї–µ–і—Г—О—Й–Є–µ —Д–∞–Ї—В–Њ—А—Л: —Б—В–Њ–Є–Љ–Њ—Б—В—М –∞–і–∞–њ—В–µ—А–Њ–≤, –Ї–Њ–Љ–Љ—Г—В–∞—В–Њ—А–Њ–≤, —Б–Њ–µ–і–Є–љ–Є—В–µ–ї—М–љ—Л—Е –Ї–∞–±–µ–ї–µ–є, —В—А–∞–љ—Б–Є–≤–µ—А–Њ–≤, —Н–љ–µ—А–≥–Њ–њ–Њ—В—А–µ–±–ї–µ–љ–Є–µ –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є—П, –Ї–Њ—Н—Д—Д–Є—Ж–Є–µ–љ—В –њ–µ—А–µ–њ–Њ–і–њ–Є—Б–Ї–Є (oversubscription), —А–∞—Б—Е–Њ–і—Л –љ–∞ —Б–µ—А–≤–Є—Б, –Ј–∞—В—А–∞—В—Л –љ–∞ –°–Ъ–° –Є —Н–ї–µ–Ї—В—А–Њ–њ–Є—В–∞–љ–Є–µ.

–Ґ–∞–±–ї–Є—Ж–∞ 1 –Є–ї–ї—О—Б—В—А–Є—А—Г–µ—В —А–∞–Ј–ї–Є—З–Є–µ –≤ –Ї–Њ–ї–Є—З–µ—Б—В–≤–µ–љ–љ—Л—Е —Е–∞—А–∞–Ї—В–µ—А–Є—Б—В–Є–Ї–∞—Е (—З–Є—Б–ї–Њ –њ–Њ—А—В–Њ–≤ –Є –Ї–Њ–Љ–Љ—Г—В–∞—В–Њ—А–Њ–≤, —Б—Г–Љ–Љ–∞—А–љ–Њ–µ —Н–љ–µ—А–≥–Њ–њ–Њ—В—А–µ–±–ї–µ–љ–Є–µ –Є —В.–і.). –Т –Ґ–∞–±–ї–Є—Ж–µ 2 –њ—А–Є–≤–µ–і–µ–љ–Њ —Б—А–∞–≤–љ–µ–љ–Є–µ —Б—В–∞—В–µ–є –Ј–∞—В—А–∞—В –і–ї—П —В—А–∞–і–Є—Ж–Є–Њ–љ–љ–Њ–є –Є –Ї–Њ–љ—Б–Њ–ї–Є–і–Є—А–Њ–≤–∞–љ–љ–Њ–є –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л. –Ъ–∞–Ї –Љ–Њ–ґ–љ–Њ –≤–Є–і–µ—В—М, –њ—А–Є –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–Є —В–µ—Е–љ–Њ–ї–Њ–≥–Є–є —Г–љ–Є—Д–Є—Ж–Є—А–Њ–≤–∞–љ–љ—Л—Е —Д–∞–±—А–Є–Ї —Б–Њ–≤–Њ–Ї—Г–њ–љ–∞—П —Б—В–Њ–Є–Љ–Њ—Б—В—М –≤–ї–∞–і–µ–љ–Є—П –≥–Є–њ–Њ—В–µ—В–Є—З–µ—Б–Ї–Є–Љ —Ж–µ–љ—В—А–Њ–Љ –Њ–±—А–∞–±–Њ—В–Ї–Є –і–∞–љ–љ—Л—Е, —Б–Њ–і–µ—А–ґ–∞—Й–Є–Љ –Њ–Ї–Њ–ї–Њ 200 —Б–µ—А–≤–µ—А–Њ–≤, –Ј–∞ 5 –ї–µ—В –≤–ї–∞–і–µ–љ–Є—П –±—Г–і–µ—В –Љ–µ–љ—М—И–µ –љ–∞ 230 —В—Л—Б. –і–Њ–ї–ї–∞—А–Њ–≤ –њ–Њ —Б—А–∞–≤–љ–µ–љ–Є—О —Б —В—А–∞–і–Є—Ж–Є–Њ–љ–љ—Л–Љ –њ–Њ–і—Е–Њ–і–Њ–Љ. –†–Є—Б—Г–љ–Њ–Ї 7 –љ–∞–≥–ї—П–і–љ–Њ –і–µ–Љ–Њ–љ—Б—В—А–Є—А—Г–µ—В –Є—В–Њ–≥–Њ–≤—Г—О —А–∞–Ј–љ–Є—Ж—Г –≤ —Б–ї—Г—З–∞–µ —В—А–∞–і–Є—Ж–Є–Њ–љ–љ–Њ–є –Є –Ї–Њ–љ—Б–Њ–ї–Є–і–Є—А–Њ–≤–∞–љ–љ–Њ–є –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л.

–Я–Њ–і–≤–Њ–і—П –Є—В–Њ–≥, –Љ–Њ–ґ–љ–Њ –Ї–Њ–љ—Б—В–∞—В–Є—А–Њ–≤–∞—В—М, —З—В–Њ –њ–µ—А—Б–њ–µ–Ї—В–Є–≤–љ–∞—П —В–µ—Е–љ–Њ–ї–Њ–≥–Є—П —Г–љ–Є—Д–Є—Ж–Є—А–Њ–≤–∞–љ–љ—Л—Е —Д–∞–±—А–Є–Ї, –≥–і–µ –і–ї—П —В—А–∞–љ—Б–њ–Њ—А—В–Є—А–Њ–≤–Ї–Є –Ї–∞–і—А–Њ–≤ Fibre Channel —З–µ—А–µ–Ј —Б–µ—В—М Ethernet –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В—Б—П –њ—А–Њ—В–Њ–Ї–Њ–ї FCoE, –∞ –∞—А—Е–Є—В–µ–Ї—В—Г—А–∞ Data Center Ethernet –њ—А–µ–і–Њ—Б—В–∞–≤–ї—П–µ—В Ethernet –±–µ–Ј –њ–Њ—В–µ—А—М –і–ї—П –Ї—А–Є—В–Є—З–љ–Њ–≥–Њ –Ї –њ–Њ—В–µ—А—П–Љ —В—А–∞—Д–Є–Ї–∞, —П–≤–ї—П–µ—В—Б—П —Н—Д—Д–µ–Ї—В–Є–≤–љ—Л–Љ —Б—А–µ–і—Б—В–≤–Њ–Љ –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є —В—А–∞–љ—Б–њ–Њ—А—В–љ–Њ–є –Є–љ—Д—А–∞—Б—В—А—Г–Ї—В—Г—А—Л –¶–Ю–Ф. –Ю–љ–∞ —Б–њ–Њ—Б–Њ–±—Б—В–≤—Г–µ—В –Њ–њ–µ—А–∞—В–Є–≤–љ–Њ–Љ—Г —А–µ–∞–≥–Є—А–Њ–≤–∞–љ–Є—О –љ–∞ –±—Л—Б—В—А–Њ –Љ–µ–љ—П—О—Й–Є–µ—Б—П —В—А–µ–±–Њ–≤–∞–љ–Є—П –±–Є–Ј–љ–µ—Б–∞ –Є –Ј–љ–∞—З–Є—В–µ–ї—М–љ–Њ–Љ—Г —Б–Њ–Ї—А–∞—Й–µ–љ–Є—О —Б–Њ–≤–Њ–Ї—Г–њ–љ–Њ–є —Б—В–Њ–Є–Љ–Њ—Б—В–Є –≤–ї–∞–і–µ–љ–Є—П —В—А–∞–љ—Б–њ–Њ—А—В–љ–Њ–є –њ–ї–∞—В—Д–Њ—А–Љ–Њ–є –¶–Ю–Ф. –Т–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М –њ–ї–∞–≤–љ–Њ–є –Љ–Є–≥—А–∞—Ж–Є–Є –Њ—В —В—А–∞–і–Є—Ж–Є–Њ–љ–љ–Њ–є –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л –Ї –Ї–Њ–љ—Б–Њ–ї–Є–і–Є—А–Њ–≤–∞–љ–љ–Њ–є –Њ–±–µ—Б–њ–µ—З–Є–≤–∞–µ—В –≤–Ј–∞–Є–Љ–Њ–і–µ–є—Б—В–≤–Є–µ –Ї–Њ–Љ–њ–Њ–љ–µ–љ—В–Њ–≤ —Б —А–∞–Ј–ї–Є—З–љ—Л–Љ–Є —В–Є–њ–∞–Љ–Є –њ–Њ–і–Ї–ї—О—З–µ–љ–Є—П, —З—В–Њ –Ј–љ–∞—З–Є—В–µ–ї—М–љ–Њ —Г–Ї—А–µ–њ–ї—П–µ—В –њ–Њ–Ј–Є—Ж–Є–Є —Г–љ–Є—Д–Є—Ж–Є—А–Њ–≤–∞–љ–љ–Њ–є –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л, –њ–Њ—Б–Ї–Њ–ї—М–Ї—Г —Г–ґ–µ —Б–µ–є—З–∞—Б –њ–Њ–Ј–≤–Њ–ї—П–µ—В —Б—В—А–Њ–Є—В—М –љ–∞–і–µ–ґ–љ—Л–є, —Б–Њ–≤—А–µ–Љ–µ–љ–љ—Л–є –±–∞–Ј–Є—Б –і–ї—П —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ–≥–Њ —Д—Г–љ–Ї—Ж–Є–Њ–љ–Є—А–Њ–≤–∞–љ–Є—П –Ї–Њ—А–њ–Њ—А–∞—В–Є–≤–љ—Л—Е –±–Є–Ј–љ–µ—Б-–њ—А–Є–ї–Њ–ґ–µ–љ–Є–є.

–Я—А–µ–і—Л–і—Г—Й–∞—П –љ–Њ–≤–Њ—Б—В—М:

–Я—А–Є–ї–Њ–ґ–µ–љ–Є–µ –Є–Ј –ї–∞—А—Ж–∞

–°–ї–µ–і—Г—О—Й–∞—П –љ–Њ–≤–Њ—Б—В—М:

–•–Њ—А–Њ—И–Њ –Ј–∞–±—Л—В—Л–µ —В–Њ–љ–Ї–Є–µ –Ї–ї–Є–µ–љ—В—Л